- keyword

- Telexistence/VR/AR

- Autosteroscopy/RPT

- Haptics/Perception

- Guide Dog Robot/Prostheses

- Bispectrum/Signal Processing

Telexistence/VR/AR

テレイグジスタンス分身ロボット TELESAR VI

TELESAR VIは、ACCEL Embodied Media Projectにおいて、身体性テレイグジスタンスプラットフォームとして開発されたアバターロボットシステムです。ロボットを自己の分身(アバター)として用い、離れていても「見て」「聞いて」「話して」そして「様々な所作」を、あたかも自分がそこにいるかのように行うことができます。

Telexistence/VR/AR

テレイグジスタンスロボット TELESAR V

TELESAR Vは、人と同期して人と同じ動作をするアバター(分身)ロボットと、ロボットの視覚・聴覚・触覚を人に伝達するコックピットにより構成されている。遠隔地にあるロボットを介して、まるで自分自身がそこにいるかのような感覚で人とふれあい、モノを操り、その接触状態や、つかんだときの感覚を伝えることができる。

Telexistence/VR/AR

実世界へのテレイグジスタンス (Telesar IV)

全周囲立体ディスプレイTWISTER、全周囲ステレオカメラVORTEX、および再帰性投影技術RPTを用いた相互テレイグジスタンスロボットシステ ムTELESAR IV を構成し、パーティ会場などの多数の人が集いコミュニケーションを行う場において、「その場にいる参加者」に加えて、「空間的に離れた参加者」も、あたかもその場にいるかのように参加し動き回り、身体性を伴ったコミュニケーションを行うことに成功した。

Telexistence/VR/AR

TELUBee: TELexistence platform for UBiquitous Embodied Experience

Movie: http://www.youtube.com/watch?v=Q5zigZDKZo8

Telexistence/VR/AR

相互テレイグジスタンスロボットTELESAR II

TELESAR IIは、従来のテレイグジスタンスロボットTELESARのように操縦者が遠隔地にロボットを介して入り込み、あたかも自分が遠隔地にいるかのように感じることができるだけでなく、遠隔地にいる人々がロボットではなく操縦者と実際にコミュニケーションをしているように感じることができる相互テレイグジスタンスを実現したロボットシステムです。

ロボットアームに対環境柔軟性を持たすためのインピーダンス制御、操作者に物体との接触感覚を与える遭遇型触力覚提示、ロボットへ操縦者を投影する再規制投影技術など多くの技術の統合システムとして研究開発が進められました。2005年の愛知万博に於いて、TELESAR IIを用いたデモンストレーストレーション実験が成功裏に行われ、相互テレイグジスタンスの概念とその有効性が実証されました。

Telexistence/VR/AR

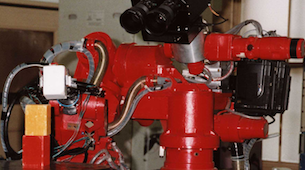

テレイグジスタンスロボット「TELESAR」

テレイグジスタンスはテレオペレーションシステムの進化したものであり、操縦者が遠隔に存在するロボットを介してあたかも遠隔の環境にいるような感覚を持ち、精密な作業やコミュニケーションを可能にする技術です。我々はテレイグジスタンスを実現するためのロボットとして“TELESAR”を開発しました。

操縦者はコンピュータが生成したバーチャル環境やバーチャル空間を介した実環境に「テレイグジスト」することも可能です。我々はテレイグジスタンスの概念を 1980 年に提唱し、この概念の実現およびロボティクス、設計およびコミュニケーションの分野への応用へ向けて研究を行なってきました。

現在では、このTELESARの後継ロボットであるTELESAR2の開発・研究を続けています。

Telexistence/VR/AR

TORSO

“TORSO”はテレイグジスタンスにおいて操縦者への自然で違和感のない視覚提示を可能とするロボットヘッドです。非常に軽量な3自由度回転機構を持つ頭部とそれを支える2自由度回転1自由度並進機構を持つ腰部からなるこのロボットは、従来のロボットヘッドでは再現することが難しかった、頭部の平行移動による運動視差を再現することができます。

さらに、頭部のパン軸を最終軸に配置することで、運動視差に重要な見回し動作の高速性をハードウェアで実現しています。また、過去の研究により確立されたHMD設計指針により最適なHMDを設計し、TORSOにより得られた遠隔映像を提示するテレイグジスタンスマスタスレーブシステムを開発しています。これにより、従来の視覚システムよりも自然で違和感のない立体映像提示が可能となっています。

Telexistence/VR/AR

Autosteroscopy/RPT

TWISTER

TWISTER とは、回転型パララクスバリアという機構を設けることで水平360度の立体映像提示を裸眼のユーザに対して行う円筒ブース型のディスプレイである。

Telexistence/VR/AR

Autosteroscopy/RPT

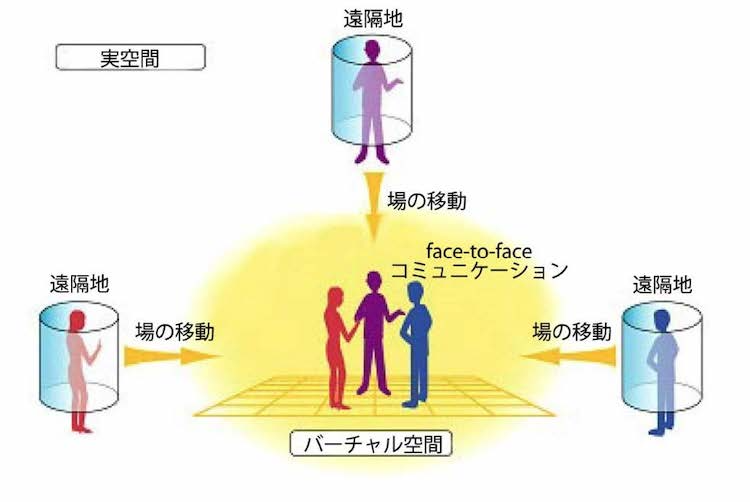

TWISTERブースを用いたメタバースにおける対面テレイグジスタンスコミュニケーション

TWISTERを用いて、バーチャル空間(メタバース)での対面コミュニケーションを実現しました。 図に示すように、人間のユーザーは離れた場所にいるにもかかわらず、TWISTERブースを利用して、あたかも対面しているかのようにバーチャル空間(メタバース)内で会うことができることが実証されました。

Telexistence/VR/AR

ロボットフォン

RobotPHONEは,ロボットの持つ身体性に着目し,ロボットを入出力インタフェースとして使用するコミュニケーションデバイスです.RobotPHONEでは,離れた場所に存在するロボットの形や動き位置等をリアルタイムに同期させることにより,ロボットの動作をお互いに交換可能にします.通常の電話が声を伝えるためのデバイスであるとすると,RobotPHONEは身振り手振りなどの動作を伝えるための新しいコミュニケーションデバイスと言えます.

Telexistence/VR/AR

RCML

R-Cubed (R3: Real-time Remote Robotics) is the concept which enables human beings to exist anywhere in the world by controlling remote robots in real time through the network. So far there exists a standardized method to describe and access virtual worlds by using Virtual Reality Modeling Language (VRML). However, accessing real environments is not considered by the cur-rent version of VRML. On the other hand, several ex-periments to control remote robots over ISDN and/or Internet are reported, but we do not have a standard method to access real environments yet. In order to provide a method to access real worlds over the network easily, we propose a language RCML (R-Cubed Manipulation Language) to describe remote robots and environments, a language RXID (RCML eXtensible Interface Definition) to define a graphical user interface for controlling remote robots, and a protocol RCTP (R-Cubed Transfer Protocol) to communicate with the remote robot site, based on the requirements for realtime remote robotics.

Autosteroscopy/RPT

再帰性投影技術,光学迷彩

RPT(Retro-reflective Projection Technology:再帰性投影技術)とは,バーチャル世界を現実世界に重畳提示するオーグメンティドリアリティを実現するための技術です.RPTによって,CG等で作られた物体が現実に実在するかのように感じられたり,SF世界のように人間の体を透明にしたりといった,様々な事が可能になります.

Autosteroscopy/RPT

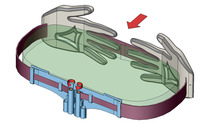

Transparent Cockpit

本研究の目的は、乗り物において死角領域を透視表示する視野外情報提示システムの構築である。ディスプレイ方式として再帰性反射材にプロジェクタで映像を投影する再帰性投影技術(RPT: Retro-reflective Projection Technology)を用いることで、乗り物の内壁部分に視野内情報と連続的に明るさや大きさなどの違和感なく視野外情報を提示できる。すなわち、乗り物の床、ドア、ピラーといった内壁部分に再帰性反射材を貼り、車外カメラで得た視野外情報を再帰性投影することで、内壁部分があたかも透明な窓であるかのような状況を実現できる。自動車はもとよりヘリコプターにこの機能を搭載すれば、床部分に提示された地面を見ながら安全に離着陸を行うことも可能となる。

Autosteroscopy/RPT

MEDIA series

HMD(頭部搭載型ディスプレイ)やCAVE等従来のバーチャルリアリティ空間の提示に主眼をおいたディスプレイに対し、バーチャルな「物体」の提示に主眼をおいた、オブジェクト指向型ディスプレイに関する研究です。オブジェクト指向型ディスプレイを利用することにより、操作者は、実際には存在しない物体をあたかも実際の物体のような感覚を持って知覚し、かつ作用することが可能となります。 現在「MEDIA-A (メディア・エース)」「MEDIA3 (メディア・キューブ)」「MEDIA X'tal (メディア・クリスタル)」の3種類のコンセプトモデルを試作しています。

Autosteroscopy/RPT

Haptics/Perception

HaptoMIRAGE

HaptoMIRAGEは,広範囲から複数人が同時に裸眼で観察できる3D映像を空中に投影する立体ディスプレイです。実空間上に情報空間をシームレスに重畳し,空中3Dスケッチやジオラマ上での3Dキャラクターとのコミュニケーションなど,実物体と3DCGが融合したインタラクションを実現します.

Autosteroscopy/RPT

RePro3D

RePro3Dは,高輝度LCDとレンズからなる高密度プロジェクタアレイを用いた投影型の立体ディスプレイ手法です.上下・左右の運動視差を持ったCGが空中に結像した3D映像を裸眼で観察することができます.

また,赤外カメラによって手と3D映像の接触状態を認識し,指先に装着した触覚提示装置によってキャラクタに触ったときの触感を生成することができます.

Autosteroscopy/RPT

Twinkle

Twinkleはプロジェクタを使った新しインタフェースです. プロジェクタの光で照らした物体を認識し,まるで光で物体に触っているかのような効果を与えてくれます.

Autosteroscopy/RPT

3次元テレビジョン

"Spinning-disc 3D Television"は見る角度によって異なる画像を表示できる立体ディスプレイと、その技術を使って立体映像を撮影し、伝送・表示を行う立体テレビシステムです。

Siggraph2007 Emerging Technologies, Asiagraph 2007にて展示をおこないました。

Telexistence/VR/AR

Autosteroscopy/RPT

Seelinder

Seelinderは、周囲360度のどこからでも立体映像を見ることができる円筒形の立体ディスプレイです。

回り込んで側面や背面まで見ることができ、しかもその際の見え方の変化(運動視差)が滑らかであるという特長があります。

また特殊なメガネ等を装着する必要はなく、多人数で同時に見ることができます。

Telexistence/VR/AR

Autosteroscopy/RPT

Haptics/Perception

さわれる情報環境

本研究は実空間コミュニケーション、ヒューマンインタフェース、メディア処理が融合した知的な触情報空間(さわれる情報環境)の構築を目指す。すなわち実空間の触覚情報の取得・理解・伝達・人への能動的働きかけの手法を確立し、人が自然環境で所作し行動しているような感覚で情報環境を利用し、遠隔コミュニケーション、遠隔体験、疑似体験を得ることを可能とするばかりでなく、デザインや創作などの創造的活動をも実世界と同様に行える人間調和型の「さわれる情報環境」を構築する。

本研究は科学技術振興事業団・戦略的創造研究推進事業(JST-CREST)『共生社会に向けた人間調和型情報技術の構築』の支援によって実施されている。

Haptics/Perception

TECHTILE toolkit

先端技術を基盤として触感を意識した価値づくりを目指すTECHTILEの活動の一環として、触感表現を身近なものにするためのツールキットを開発しています。触感の記録と再生を行うユニットを組み合わせることで、触体験の記録/伝達/共有/加工といった、触感を用いた新しい表現手法を手軽に始めることができます。

Haptics/Perception

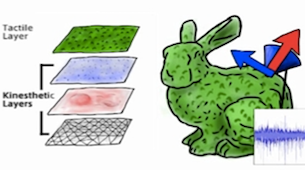

Haptic Editor

力覚のみならず,触感をも伴う3DCGコンテンツとのインタラクションを実現するには,触感情報をマッピングされた3DCGモデルを制作することが必要となります.そこで触原色原理に基づく触感覚要素に対応した触感レイヤ構造を有する「さわれる3Dモデル」を構成し,その表面に分布する触感情報を編集することが可能なHapticEditorを開発しています.

Haptics/Perception

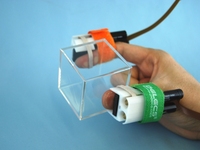

GravityGrabber

Gravity Grabberは,空の箱やグラスの中に,まるで何かが入っているかのような感覚を提示するシステムです.実際には存在しない物体の重さや慣性質量の提示を,指先に装着するシンプルなデバイスで実現しました.

近年,DUALSHOCK(Sony)やWiiリモコン(任天堂)など,触覚フィードバック機能を持ったユーザインタフェースが一般家庭にも普及しつつありますが,現状で提示できる触覚は振動感覚に留まっています.そこで今後,ホームユースのユーザインタフェースにおける触覚フィードバックをより高臨場感なものとするために,小型・安価な機構で効果的な触覚体験を提示可能な手法の開発が求められていると考えられます.

私達は存在感の高い触覚インタラクションを手軽に体験することができるようにするため,バーチャルな物体の質量,すなわち重量と慣性質量の双方を提示可能な指先装着型の触力覚ディスプレイを開発しています.

Haptics/Perception

GhostGlove

“GhostGlove”は,手全体(てのひらと各指)に力覚を提示する,グローブ型のインタフェースです.各部位への力の提示は,“GravityGrabber”と同様のモータとベルトを用いたシンプルな機構によって行われ,それらが手の動きにあわせて連携することで,バーチャルな世界において“そこに存在しいないものを触る”体験を提供します.

Haptics/Perception

Pen de Touch

Pen de Touchは, バーチャルな物体に触った力を提示する触覚ディスプレイであり, ペン型のデバイスを介して様々な物体に触った感覚を再現することができます. 体験者は, デバイスを持って空間中で手を動かすことで, 立体映像として目の前に浮かんできるバーチャルな物体を触って感触を楽しんだり動かして遊んだりすることができます.

Haptics/Perception

Pen de Draw

Pen de Drawは, 空中で絵を描くような感覚で触れる立体映像を作成可能なシステムです.ペン型力覚ディスプレイPen de Touchをインタフェースとして用いており,空中に配置したバーチャルなキャンバスの上で図形を描くという簡単な操作で様々な立体形状を作成することができます.作成したモデルは立体映像として見るだけでなく,デバイスで触って体験することが可能です.

Haptics/Perception

HAPMAP

HAPMAPは手すりを伝う感覚による触覚ナビゲーションデバイスです。”視線や意識が手元に集中してしまう” ”会話や音楽、都市のサウンドを楽しめない”ナビゲーションによる視覚・聴覚の制限は都市経験を損なわせます。直感的でナチュラルなインターフェース、カーブの詳細まで誘導可能な性能、シンプルな構造により、都市を楽しむ上で必要な感覚を損なうことなく目的地へと誘導します。

Haptics/Perception

触覚情報伝送

先端技術を基盤として触感を意識した価値づくりを目指すTECHTILEの活動の一環として、触感表現を身近なものにするためのツールキットを開発しています。触感の記録と再生を行うユニットを組み合わせることで、触体験の記録/伝達/共有/加工といった、触感を用いた新しい表現手法を手軽に始めることができます。

Haptics/Perception

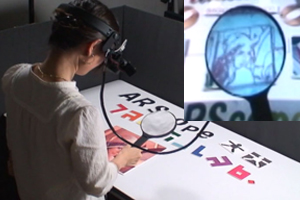

ARScope

ARScopeとは頭部搭載型プロジェクタを用いたARのための新しいインタフェースです.虫眼鏡型のデバイスを覗くことで,実世界に重畳されたバーチャルな情報を観察することができます.

Haptics/Perception

ARForce

ARForce is a novel force vector sensor for various applications of augmented reality. ARForce enables users to measure the 3D position of markers as well as also the distribution of force vectors that are applied by a user. Using this system, users can manipulate virtual objects using various finger motions.

Haptics/Perception

Colorful Touch Palette

“Colorful Touch Palette” is a novel interactive painting interface that provides us a rich tactile sensation. Users can select various tactile textures, paint the textures on the canvas, and experience the tactile sensation of paints with the electrotactile stimulation. The interface could be used to design spatial tactile patterns for surface prototyping or support innovations in artistic tactile paints.

Haptics/Perception

Pop Up!

Pop Up! is an innovative approach to display 3D objects by orchestrating the vertical motion of a dense array of pin-rods. The effect is similar to a children's "Pop up book", where a flat surface transforms into a 3D form. Each pixel is composed of a simple component, and the driving method is scalable so that displays of any size can be constructed in the same way.

Haptics/Perception

Haptic Video

熟達した技術の指導は通常,熟練者の作業を記録したビデオなど伝統的手法によって行われる.知識を伝達する手法はさまざまな手法が存在するが,身体運動を伴う技術を伝達する技術はほとんどない.しかしながら,訓練は主体的に行う事で最も効果を得られる.

そこで我々は熟練者の作業を記録し,それを力覚提示装置で動的に再生する"Haptic Video"を提案する.この"Haptic Video"は前述のHaptic Teachingの手法に類似するが,環境情報をインピーダンス情報に変換し,作業に同期した視覚情報を付加することで,動作に応じた熟練者作業の簡便な記録と再生を実現している.

Haptics/Perception

Guide Dog Robot/Prostheses

SmartFinger

「SmartFinger」はセンサと触覚提示装置が組み合わされた触覚のオーグメンテッドリアリティシステムとしてSmartToolの次に開発されました.特に指先における触覚のAR を狙っい,指の爪側にセンサと振動子を装着する構成になっています.爪側からの駆動力によって,玉突きのように間接的に指腹部と接触対象の間に応力を発生させ,皮膚感覚を提示しています.システムを爪側に搭載することで,現実の触覚を損なわないAR を実現しています.

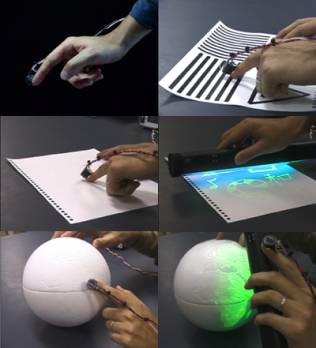

Haptics/Perception

SmartTouch

「SmartTouch」はセンサと触覚提示装置が組み合わされた触覚のオーグメンテッドリアリティシステムとしてSmartTool,SmartFingerについでに開発されました.試作システムでは提示部に電気刺激を用い,さらに実世界センサとして光センサを用いることで画像情報を皮膚感覚情報に変換します.

Autosteroscopy/RPT

Haptics/Perception

SmartTools

「SmartTool」はセンサと触覚提示装置が組み合わされた触覚のオーグメンテッドリアリティのためのシステムで,実際の触覚情報とバーチャルな触覚情報を併せて人に提示することで人間の持つ触覚を拡張します.例えばセンサで物体の表面の凸凹を計測してそれを拡大して提示したり,ゆで卵の色の違いを読みとって,黄身の周りに実際にはない壁を作り出し,黄身を傷つけずに白身だけ切ったりと言うことが可能になります.これは医療の分野での応用が可能で,体内に手術道具が侵入してはいけない領域を設定し,そこに近づくと反力を生成することで,間違ってもその部位を傷つけないようにするといったことが可能になります.現在は実際に医療応用に関する研究が進められています.

Haptics/Perception

AED

AED(Active Environment Display)はバーチャルリアリティにおいて物に触った感覚,触覚を提示する装置の一種です.一般的には力を提示する触覚提示装置が多いですが,これは任意の物体の形状をまねる装置を使って触覚を提示します.人は装置により近似された物体形状にさわることで触覚を得ます. 原理的には,先端に物体形状の素片が搭載し,これを適切に制御することで任意の物体の表面の近似を可能にします.

Haptics/Perception

Affective Haptics

Driven by the motivation to enhance emotionally immersive experience of communication in Second Life, we propose a conceptually novel approach to reinforcing own feelings and reproducing the communicating partner’s emotions through affective garment. The emotions detected from text are stimulated by innovative haptic devices.

Our goal is to enhance emotionally immersive experience of real-time messaging in 3D virtual world Second Life through haptic system. In the developed system, great importance is placed on (1) automatic sensing of emotions (2) visualization of the detected emotions (3) enhancement of user’s affective state, and reproduction of feeling of social touch by means of haptic stimulation.

For the automatic detection of emotions from text we developed an Affect Analysis Model, capable of recognition of nine emotions on the level of individual sentences, and integrated it into Second Life through the scripted 3D object EmoHeart. The developed system is intended for the influencing on communicating partners’ emotions (namely, ‘anger’, ‘fear’, ‘sadness’, and ‘joy’) by physiological changes, physical stimulation, social touch, and emotional design. In order to support the affective communication, we implemented several novel haptic gadgets.

When people are hugging, they generate pressure on the chest area and on the back of each other by the hands, simultaneously. The key feature of the developed HaptiHug is that it physically reproduces the hug pattern similar to that of human-human interaction. The important feature of our system is that we integrate active-haptic device “HaptiHug” and pseudo-haptic touch simulated by haptic animation. Thus, high immersion into the physical contact of partners while hugging was achieved.

Haptics/Perception

Guide Dog Robot/Prostheses

視覚障害者向け額網膜システム FRS

詳細は下記Webサイトをご覧ください

株式会社アイプラスプラス

- http://www.eyeplus2.com/

- 視覚障害者向け"額で見る"システム AuxDeco

Guide Dog Robot/Prostheses

盲導犬ロボット

盲導犬ロボットという概念を世界で初めて提唱するとともに、このアイディアの工学的な実現法を理論的に研究し、この方法で実際に実現可能であることを、MELDOGと呼ぶ実験用ロボットを試作し具体的に示しました。この研究は1977年度から6年計画で工業技術院の特別研究「歩行誘導機械の研究」として行ったものであり、移動ロボットの知的なナビゲーション技術と人間と機械のコミュニケーション技術とを確立し盲人の街路歩行補助を行うための基礎的な研究です。MELDOGと呼ばれる試作実験装置のMARK IからMARK IVが試作され、それらを用いた実験の結果、盲導犬ロボット実用のための技術的な可能性が実証されました。