Summary

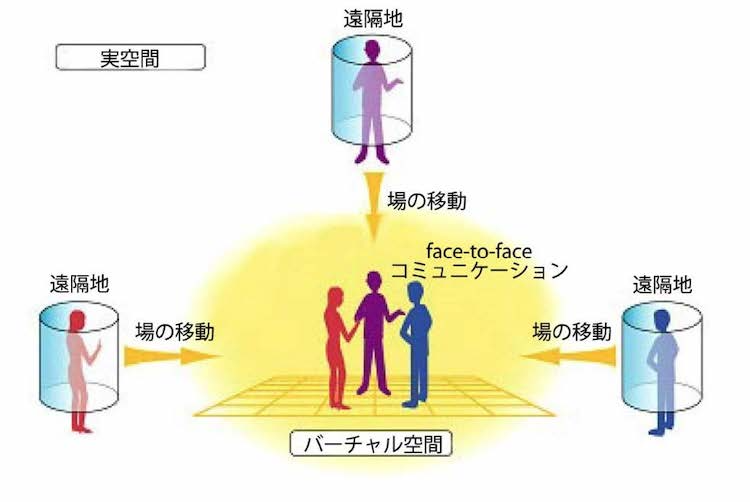

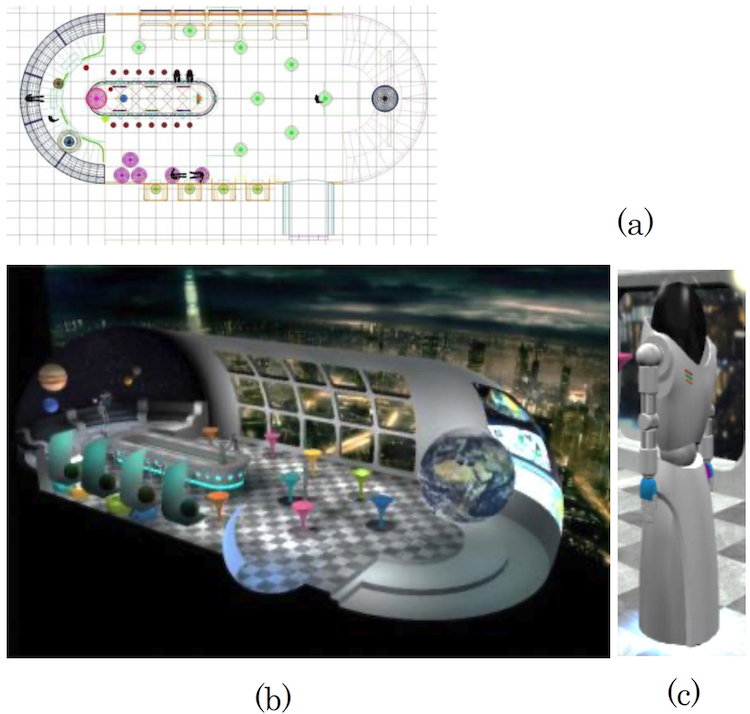

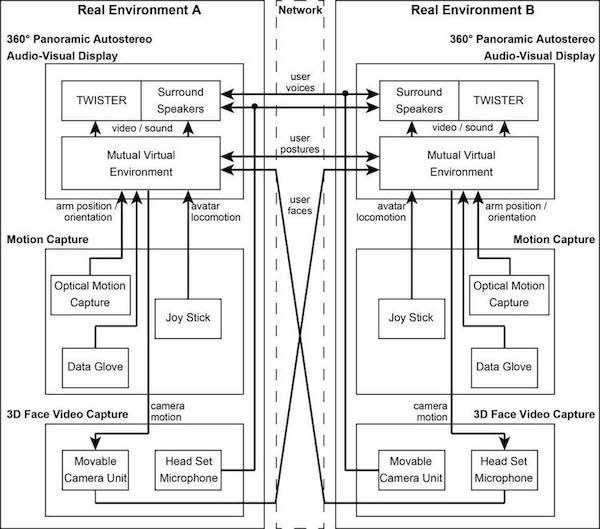

TWISTERを用いて、バーチャル空間(メタバース)での対面コミュニケーションを実現しました。 図1に示すように、人間のユーザーは離れた場所にいるにもかかわらず、TWISTERブースを利用して、あたかも対面しているかのようにバーチャル空間(メタバース)内で会うことがでることが実証されました。

まず、各ブースには360度の3Dバーチャル環境が表示されます。次に、各ブースに設置された2台のステレオカメラで、バーチャル環境における3人のユーザーの相対的な位置と向きを基に算出した角度から、ブース内のユーザーを撮影します。撮影された画像は、通信回線を使って他のTWISTERに送信されます。各ブース内では、他の2人のユーザーの姿が、相対的な位置と向きに応じてバーチャル環境内に配置されます。 こうすることで、ユーザーはバーチャル環境の中で自分が近くにいることを感じることができるのです。

ネットワークテレイグジスタンスの概念に基づく技術により、ユーザーは遠隔地にいても、あたかも同じ空間と時間を共有しているかのように出会い、会話することができます。 これは、相互テレイグジスタンス通信システムの開発の目標であり、電話からテレイグジスタンス-テレビ電話への自然な流れとなります。

図1:TWISTERブースを利用した対面コミュニケーション

開発したシステムは、バーチャル環境(メタバース)をコミュニケーションの場とするテレコミュニケーションシステムとして設計されており、複数人による臨場感あふれるテレコミュニケーションを実現することが可能です。本システムは、次の3つの条件を満たすように設計されています。(1)バーチャル環境はリアルな視聴覚特性を持つこと、(2)対面でのコミュニケーションはアイコンタクトが可能であること、(3)バーチャル環境内の参加者は身体を持ち、それが自分のものであると感じられること、です。このようなシステムを設計・構築し、その有用性を検証しました。

具体的には、TWISTERの全方位3D裸眼ディスプレイに、表情や視線を取得する3D顔画像取得システム、腕や手の位置や向きを取得するユーザー動作取得システムを加え、バーチャル環境下でアバターを介してコミュニケーションを行う統合システムを構築しました。そして、このシステムが設定した条件を満たしていることを確認するための評価を行いました。さらに、2人の被験者にTWISTER同士の遠隔通信を実際にオンラインで行わせることで、共有バーチャル環境において相互に等価な条件で遠隔通信が可能であることを検証しました(Watanabe et al.2012)。

Koichi Watanabe, Kouta Minamizawa, Hideaki Nii and Susumu Tachi: Telexistence into cyberspace using an immersive auto-stereoscopic display, Trans. of the Virtual Reality Society of Japan, Vol.17, No.2, pp91-100 (2012.6) [in Japanese] [PDF]

| 全方位型3D映像提示システム | バーチャル環境(メタバース)と身体性を持ったアバター | 3次元フェイシャルキャプチャシステム |

| モーションキャプチャシステム | 統合システム | 通信システムの実証実験 |

全方位型3D映像提示システム

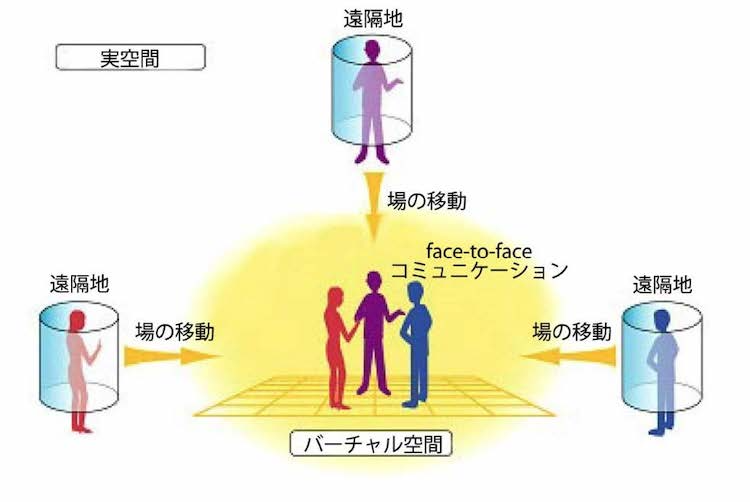

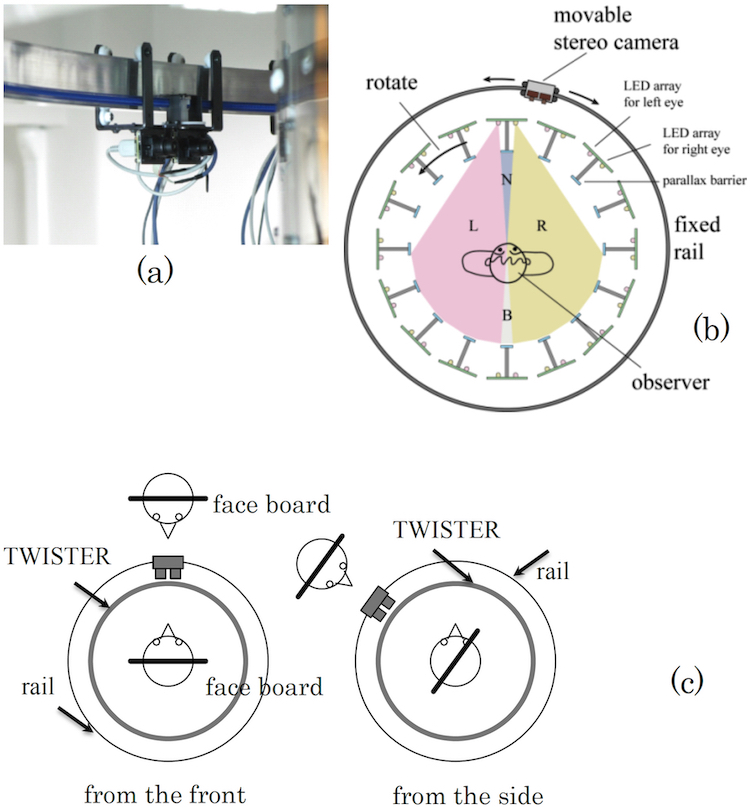

バーチャル環境の視聴覚映像を提示するディスプレイとして、TWISTER V を使用しました。TWISTER Vは、TWISTER IVと同様に、左右の目にそれぞれ独立したLEDアレイを持つ36台のLEDディスプレイを用いて両眼画像を表示します。これらは、ユーザーを中心とした半径1mの円周上に等間隔で配置され、回転させながら表示されます。視差は回転する視差バリア機構によって表現されるため、メガネなどの特別な器具は必要なく、どの角度から見ても裸眼で3D効果が得られます。

図2はTWISTER IV、Vで採用した可動式パララックスバリア方式の原理図で、各ディスプレイユニットには左目用、右目用の2つのLEDアレイが搭載されています。 各ユニットは約1.7回転/秒の速度で回転し、コントローラーが表示更新を同期させることで60フレーム/秒の実効フレームレートを実現しています。

図2: 可動(回転)式パララックスバリア方式の原理

パララックスバリアが左右の反対側からのLED発光を見えなくするため、左右の目には異なる映像が表示されます。つまり、エリアLとRにはそれぞれ左目用と右目用の映像のみが観察されるのです。バリア付き表示器がユーザーの周りを回転すると、これらのエリアも同じように回転します。従って、ディスプレイが回転しても、立体視の状態は維持されるのです。

バリアは、人間の目が1秒間に約500度しか回転できないのに対し、1秒間に600度という高速で回転するため、バリアそのものを観察することはできませんので、映像のみが立体的に見えるのです。 これにより、360度のパノラマ立体視を実現しています。

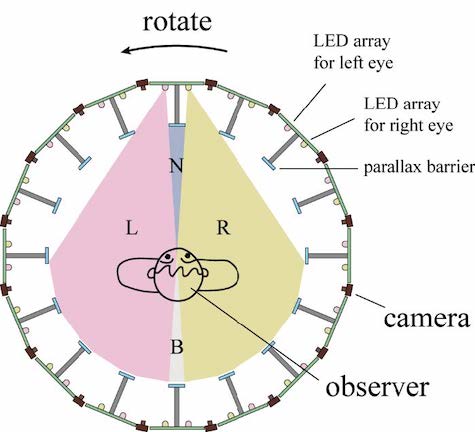

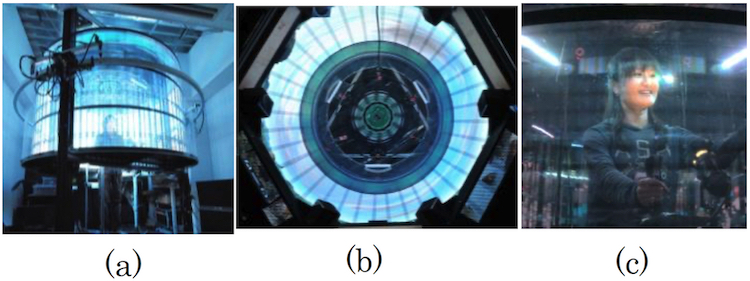

TWISTER Vのディスプレイ解像度は3162×600ピクセルで、リフレッシュレートは60fpsです。ユーザーは回転部の中で上半身を自由に動かすことができます。図3(a)はTWISTER Vの外観、図3(b)は内部を下から見た全周囲の様子を示しています。さらに、高速に回転して映像を表示するため、LEDユニットを貼り付けた円筒面は外から見ると透明になっており、外から中のユーザーをはっきりと見ることができます(図3(c))。

図3:TWISTER V:(a)外観、(b)内側から見た提示部、(c)外側から見たユーザー

また、TWISTER Vにはスピーカーが搭載されており、回転部の底面から全周囲の音響を提示することができます。6つのスピーカーは、外周に沿って60°の間隔で配置されており、音の指向性を持たせることができます。これにより、バーチャル環境内の環境音やユーザーの発話を、全周囲に沿った空間内の音として調整し提示しています。

| 全方位型3D映像提示システム | バーチャル環境(メタバース)と身体性を持ったアバター | 3次元フェイシャルキャプチャシステム |

| モーションキャプチャシステム | 統合システム | 通信システムの実証実験 |

バーチャル環境(メタバース)と身体性を持ったアバター

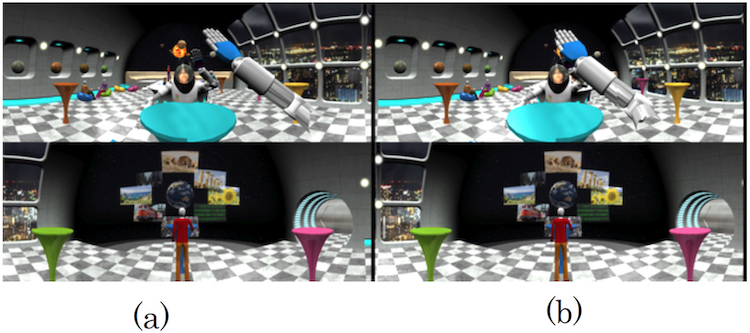

TWISTER IVとVを用いて、図4(a)と(b)に示すようなバーチャル環境を構築しました。ユーザーはアバターを通じて、他人の表情やジェスチャーをリアルタイムに観察しながらコミュニケーションをとるテレイグジスタンスが体験できます。バーチャル環境内の空間は14×10mの広さで自由に移動できます。環境は近未来的なバーをイメージし設計されており、バーカウンターやテーブル、人型キャラクターなどのオブジェクトが配置されています。また、バーカウンターにはグラスが置かれており、ユーザーアバターはグラスを握ったり手に取ったりすることができるのです。なお、映像は30fpsのリフレッシュレートを維持できるように設計されています。

図4:構築されたバーチャル環境(メタバース) (a) バーカウンターを備えたバーチャル会議室の設計図,(b) その透視図,(c) テレイグジスタンスコミュニケーションに用いるアバター

アバターとして使用するために全身を撮影することは可能ですが、そうするとその画像を相互に伝送することで通信の遅延が発生します。そこで、コミュニケーションには顔の情報が重要であることから、頭部のみを実写に置き換えたCGでアバターを作成しました。首から上の映像をCGに置き換えただけでは、違和感があります。そこで、透明なヘルメット付きの宇宙服を着たアバターをデザインし、ヘルメットの中にユーザーの頭部の映像を表示しました。これにより、あたかもコミュニケーション相手が宇宙服を着ているかのように見え、不自然さが軽減されました。身体性は、腕や手の位置や向きの情報を検出し、アバターの腕を適切に動かすことで十分に表現できるため、システム間ではそれらの情報のみを送ればよいことになります。そこで、バーチャル環境内にあらかじめ存在するアバターにユーザーが入り込み、その中で自由に動けるように設計しました。

図4(c)は、バーチャル環境におけるアバターです。アバターの身長と肩幅は,一般的な成人男性と同等にしてあります。腕は肩2、肘2、手首3の7自由度、手は親指3、他の各指に1、外転1の都合8自由度です。アバターは、人間の足のような機構では制御が難しく、映像空間の上下移動が気になるため、地面と平行に移動する車輪のような移動機構を採用しています。この移動機構を採用することで、2次元のフィールド上での移動を制御することが可能になりました。

ユーザーの顔画像を埋め込む顔部分は、透明なヘルメットの中にある楕円形の平板(以下、顔ボード)です。これが回転してユーザーの真正面を向き、その位置情報をもとに、正面、横顔、後頭部の画像を適切に貼り付けます。フェイスボードに画像を貼り付けることで、頭の大きさが異なるユーザーでも、ユーザーごとにアバターを作り直すことなく利用することができます。

| 全方位型3D映像提示システム | バーチャル環境(メタバース)と身体性を持ったアバター | 3次元フェイシャルキャプチャシステム |

| モーションキャプチャシステム | 統合システム | 通信システムの実証実験 |

3次元フェイシャルキャプチャシステム

図5に、ユーザーの顔撮影に使用したTWISTERカメラシステムの詳細を示します。TWISTERの透明性を活かし、外周部に自走式ステレオカメラを搭載しています。TWISTERの内部は外部から見ることができますが、外部を暗くすることで内部からは表示された映像のみが見えるようになっています。これにより、ユーザーはカメラの存在を無視することができ、よりバーチャル環境に没入することができます。また、TWISTERは顔に3D眼鏡などをかける必要がないため、ユーザーの表情を直接動画で撮影することができます。

図5(a)は自走式カメラ、図5(b)はその上を走る半径1.2mの円形レールを示しています。実際には、複数のカメラがTWISTERの外周に沿って、中心を向くように走行しています。レールはTWISTER装置内のユーザーの目の高さに配置され、身長の異なるユーザーにも対応できるよう昇降させることができます。自走式ステレオカメラは、人間の平均的な目の間隔を模してカメラ素子(Firefly MV, Point Grey Research)を65mm間隔で配置し、底面に取り付けたモーターでレール上を自由に自走し移動することができます。水平方向と垂直方向の視野角はそれぞれ17°と13°であり、1.2mの距離から0.36×0.27mの領域を撮影することができます。日本人男性の顔の平均長さは、0.24mなので、この範囲であれば十分です。画像サイズは640×480ピクセルで、リフレッシュレートは30fpsです。

マルチユーザーへの対応や配線などの機械的な問題を考慮し、TWISTER周辺を3つのエリアに分け、各エリアに2台の自走式カメラを設置しました。カメラは、TWISTER環境内の他のユーザーの位置や向きに関する情報をもとに、ユーザー画像を取得すべき角度を決定し、その場所に移動して撮影を開始します。これにより、アバターとカメラの方向性を合わせることができ、カメラがアバターの目となって、他のユーザーの視線に合わせて顔画像を取得することができます。取得した画像は、他のユーザーに送信され、撮影したユーザーを表すアバターに貼り付けられます。アバターデザインの項で述べたように、顔ボードが常に他のユーザーと向き合うように回転するので、カメラで撮影した画像をそのまま顔ボードに貼り付けて、他のユーザーが適切な位置情報に従って顔を見ることができるのです。

図5(c)は、アバターとフェイスボードの位置関係を示したものです。撮像されたユーザーを見ながら他のユーザーが横に移動すると、撮像されたユーザーの横顔が撮像され、フェイスボードに貼り付けられるため、適切な3D映像が提供されます。少数のカメラであらゆる方向から映像を取得できるため、バーチャル環境内の他のユーザーそれぞれに自走式のカメラを1台ずつ割り当てるのではなく、他のユーザーとの位置関係を利用して、必要に応じてカメラを切り替えながらリアルタイムで適切に映像を選択することができます。カメラの切り替えの際には、新しいカメラは撮像しているカメラにできるだけ近い位置に移動し、切り替えをスムーズに行うことができます。以上のような仕組みと制御により、視線を合わせることが可能な通信を実現しています。

図5:移動型ステレオカメラ (a) 全体像、(b)TWISTERとカメラの移動軌道 、(c) アバターの顔ボードとカメラの関係

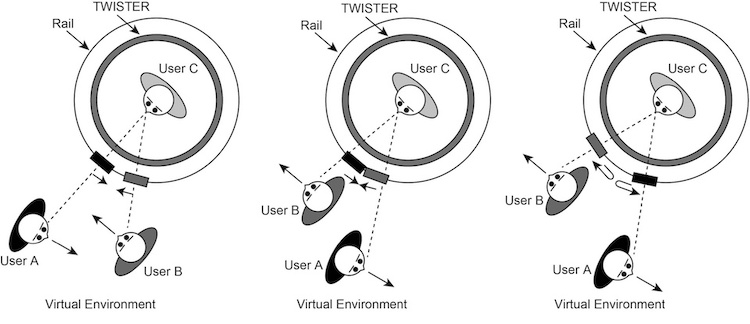

同じバーチャル環境内に3人以上のユーザーがいる場合、それぞれに適切な位置から撮影できる位置に移動できるカメラを割り当てます。バーチャル環境内で他のユーザーがすれ違う場合は、割り当てたカメラを変更する必要があります。図6に、2人のユーザーがすれ違った場合のカメラの割り当て変更の例を示します。左図のような位置からスタートした2人のユーザーが互いに向かっていく場合、中図のような構成となり、2台のカメラはほぼぶつかる位置まで移動することになります。

ユーザーがすれ違う際、カメラ空間の位置関係はそのままに、ユーザーAから見てユーザーCを撮影していたカメラはユーザーBの視点となり、ユーザーBから見てユーザーCを撮影していたカメラはユーザーAの視点となるように、カメラの割り当てが電子的に切り替わり、右図の状態となり、新たに割り当てられたユーザーの撮影を継続します。このようにカメラの割り当てを制御することで、複数のユーザーがバーチャル環境内を移動する場合でも、カメラ位置の物理的な制約を受けることなく、連続的に3D顔画像を撮影することができます。また、ヘッドセットを使用することで、表情や目や口の動きを妨げずに音声を取得することができます。

図6:2人のユーザーがすれ違ったときのカメラ切り替えのアルゴリズム

| 全方位型3D映像提示システム | バーチャル環境(メタバース)と身体性を持ったアバター | 3次元フェイシャルキャプチャシステム |

| モーションキャプチャシステム | 統合システム | 通信システムの実証実験 |

モーションキャプチャシステム

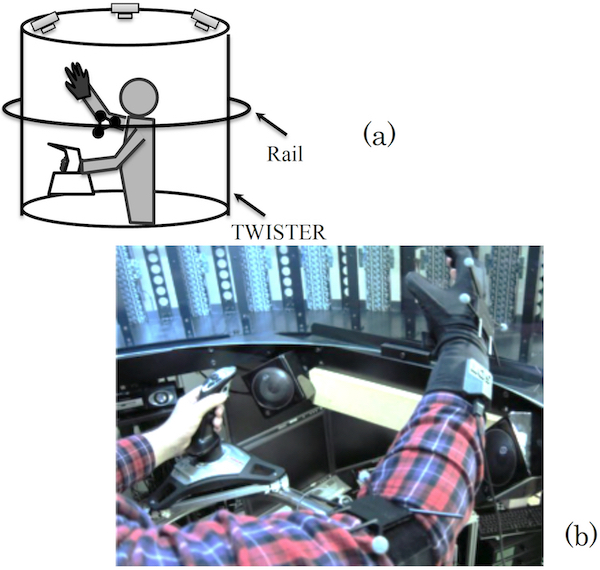

本システムでは、光学式モーションキャプチャとジョイスティック入力を組み合わせて手や腕の位置情報を取得し、物体の把持や移動、ジェスチャーを行う際に直感的な身体性を実現しています。モーションキャプチャには接触型と非接触型がありますが、ジェスチャーをより許容するために、測定精度よりも動作制約の少なさを重視した非接触型を採用しました。

ただし、非接触方式の制約として、手の動きのオクルージョンがあり、把持や指のジェスチャーにはある程度の安定性が求められるため、データグローブを装着することにしました。一方アバターの移動は、ジョイスティックで制御します。アバターのデザインは、地面と平行な全方位車輪の動きを想定した脚部であるため、足を使った歩行動作などの直接入力方式よりも、ジョイスティックによる動作制御の方が適しているからです。

図7は、TWISTERのユーザモーションを取得するためのシステムの詳細を示しています。右腕に赤外線光学モーションキャプチャシステム(OptiTrack V100:R2, NaturalPoint, Inc.)を装着し、回転体TWISTER内のユーザーの上半身全体が半径1mの範囲で撮像できるよう赤外線カメラを配置しています。3次元空間内の絶対位置は、右腕の手首、肘、肩の赤外線マーカーで計測しています。

肩の位置を基準にして手首の位置を計算し、肘の位置を考慮した逆キネマティクスで関節角度を計算しています。この情報をアバターに伝えることで、肩に対する手の位置と向きから得られる腕の6自由度と肘の1自由度を、7自由度で完全に再現することができるのです。なお、マーカー位置は10ms以下のレイテンシーで計算可能です。

右手にはデータグローブ(5DT Data Glove Ultra, Fifth Dimension Technologies)を装着し、手の動きを取得します。このグローブは5本の指の関節角度を取得することができます。データグローブで取得できる5自由度以外の自由度は、取得した情報から推測して計算します。データグローブからのレイテンシーは13ms以下です。グリップジェスチャーは、データグローブからのデータを用いバーチャル環境内のコップなどの可動物を考慮して解釈され、グリップジェスチャーを使って、可動物を自由に動かすことができます。左腕や左手にはモーションキャプチャ装置はなく、ジョイスティックを用いたバーチャル環境内の移動に特化しています。ジョイスティックは3自由度(前後移動、左右移動、時計回り・反時計回り回転)であり、バーチャル環境内を自由に移動することができます。また、アバターも左手にジョイスティックを持ち、ユーザーの動きに合わせて操作することで、ユーザーの動きとアバターの動きに連続性を持たせています。

図7: ユーザーの手の動きをキャプチャするシステム (a) モーションキャプチャシステム配置の全体図、(b) 光学マーカーとジョイスティックの配置

| 全方位型3D映像提示システム | バーチャル環境(メタバース)と身体性を持ったアバター | 3次元フェイシャルキャプチャシステム |

| モーションキャプチャシステム | 統合システム | 通信システムの実証実験 |

統合システム

図8は、図1の概念図に従って、TWISTERを2台組み込んで構成した通信システムを示しています。この全方位型3Dオーディオビジュアルシステムは、画像提示にTWISTERを用い、周辺スピーカーでバーチャル環境情報を共有します。動作取得システムは、光学式モーションキャプチャ、データグローブ、ジョイスティックを用い、ユーザーの手や腕の位置や向きの情報をもとに、アバターの動作を計算してシステムに送出します。ユーザーの顔画像や発話以外の情報も収集し、バーチャル環境間の差分情報をUDPプロトコルを用いて相互に送信し、バーチャル環境の変化を反映させます。

3D顔画像システムは、移動カメラユニットとヘッドセットマイクを備えています。移動カメラユニットは、バーチャル環境のアバター位置関係から必要なカメラ動作を決定し、自走式ステレオカメラが適切に配置されるように制御します。撮影されたユーザーの顔画像は、ネットワークを介して他のユーザーのバーチャル環境に直接送信されます。ヘッドセットマイクで取得したユーザーの発話は、ネットワークを介してバーチャル環境内のユーザーや他のユーザーの周辺スピーカーに送られ、環境音とともに提示されます。

図8:提案するテレイグジスタンス通信システムの構成

| 全方位型3D映像提示システム | バーチャル環境(メタバース)と身体性を持ったアバター | 3次元フェイシャルキャプチャシステム |

| モーションキャプチャシステム | 統合システム | 通信システムの実証実験 |

通信システムの実証実験

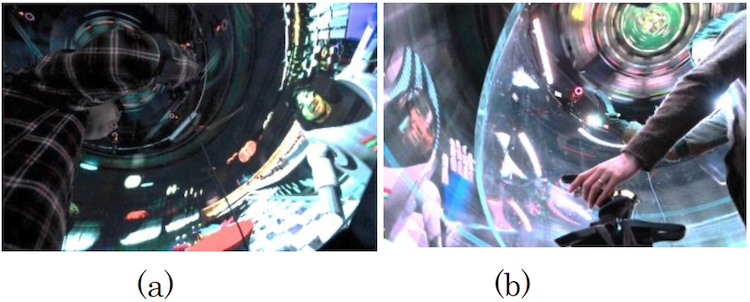

通信システムの検証として、バーチャル空間を共有しながら円滑な通信を行うために必要な要件を十分に満たすかどうかを調べる通信実験を行いました。実験は、TWISTERを使用して1対1の通信を行う遠隔地のユーザー2名で行いました。ユーザーは東京大学本郷キャンパス(東京都文京区本郷)と慶應義塾大学日吉キャンパス(横浜市日吉区)に設置されています。2つのTWISTERシステム間のネットワークとして、10GBの専用イーサネット回線を使用しました。参加者は20代6名(各拠点3名ずつ)で、各拠点で2組の参加者が順番に約30分ずつ、1組が約2時間使用しました。図9に、TWISTERに投影されたバーチャル会議の実験中の状態を示します。

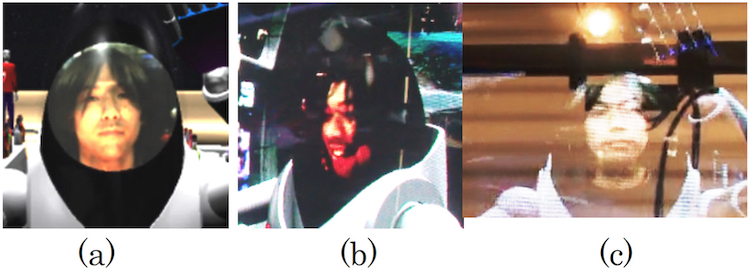

図9:TWISTERで投影されるバーチャル会議室の例:(a)左目用、(b)右目用

図10(a)は正面から見た顔画像をアバターの顔領域に投影したものであり、図10(b)は側面から見た顔画像を投影したもので、適切な3Dプロファイル画像として表示されていることが分かります。図10(c)は、TWISTERの外部照明の明るさを調整して、ステレオカメラとアバターの双方が見えるようにして、それらの位置関係を示したものです。ステレオカメラはアバターの顔の位置と重なっており、視線は自然に合っていることが分かります。

図10:テレイグジスタンス通信におけるユーザーアバター (a)ユーザーの顔の正面図、(b)ユーザーの顔の側面図、(c)アバターと重なるカメラ

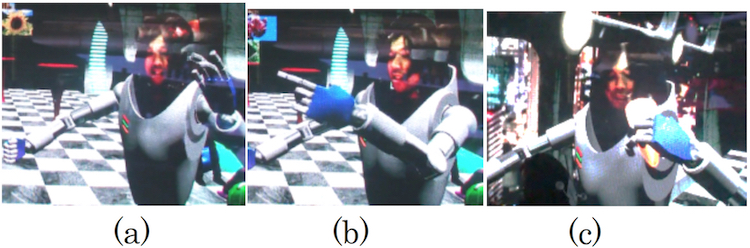

また、人間に近い身体性を持つアバターが、バーチャル環境において、自由な移動、ジェスチャー、グラスなどのバーチャル物体の移動に利用できることも検証しました。

図11(a)(b)は、ユーザーが手を振ったり指差したりするジェスチャーを行っている様子を示しています。

図11:身振り手振り (a)手を振る動作、(b)指差す動作、(c)飲む真似をする動作

構築したシステムの部品性能が、許容できるレイテンシーで動作表現が可能であることを各部の遅延から論理的に検証しました。まず手や腕の動きのレイテンシーは、データグローブのレイテンシー定格が13msであることをもとに算出しました。PCで計測データを取得し、UDP送信の準備をすると、約10msのレイテンシーが発生し、その後送信する。ネットワーク経由で転送されるデータは、アバターや移動体の位置・姿勢に関するものだけなので、非常に小さい(約100バイト)ことから、転送のレイテンシーは10ms程度です。UDPパケットの受信処理に約10ms、これらのデータを提示画像に反映させるのに最大で30msかかる。合計で73msとなります。人間の遅延知覚の限界が100〜200msであることを考えると、これは十分に小さいと考えられます。

また、コミュニケーション相手の顔画像についても同様のレイテンシーの推定を行い、視覚情報のレイテンシーを推定した。処理時間を要するステップは、画像取得(30ms)、PCキャプチャ(30ms)、エンコード(約10ms)、送信・共有ファイル作成(約30ms)、読み込み・デコード(約30ms)、画像更新(30ms)で、合計160msと見積もられました。これは、許容遅延時間100~200msを基準にするとかなり高いが、上限値内です。顔画像による表情については、音声やジェスチャーのレイテンシーが知覚可能な限界以下であれば、多少のレイテンシーも許容されると思われ、手や腕のジェスチャーのレイテンシーは約73msなので、共有空間の同期は十分達成されていると考えられます。また、使用するネットワークの性能からすると、交換するデータ量は非常に少ないので、伝送遅延の要求範囲内であれば、参加ユーザーや可動物体の数を増やすことも可能であると考えられます。

図12は、統合システムにおけるテレコミュニケーションの結果を示したものです。図7.36(a)は慶應義塾大学のTWISTERブースであり、(b)は東京大学のブースです。実験の基本的な流れを大きな問題なく実施できることを確認しました。

図12:TWISTER同士の通信 (a) 慶應義塾大学のTWISTER Vから見た様子、(b) 東京大学のTWISTER IVから見た様子

実験参加者の主観的な評価では、バーチャル環境でのインタラクションが現実世界でのインタラクションに近い感覚を呼び起こすという点で一致していました。また、ある参加者は、自分の身体がバーチャル環境に移動したというよりも、ツイスターブースそのものが移動したような体験ができたと報告しています。これは、宇宙服のような服装でバーチャル環境に入ることで、没入感に近い感覚を得られるという意味だと解釈しています。また、「あそこ」「ここ」など現実世界でよく使われる指示代名詞が自然に理解でき、コミュニケーションが取りやすいという意見もありました。このような定性的な結果からも、提案した要件がすべて満たされ、身体性や意思の伝達を含むテレコミュニケーションが実現されたといえます。