| テレイグジスタンスとは | テレイグジスタンスの現在 | テレイグジスタンスの社会実装 | テレイグジスタンスとテレプレゼンスの違い |

| テレイグジスタンス黎明期 | テレイグジスタンス発見の瞬間 | テレイグジスタンスはいかにして生まれたか |

| 大型プロジェクト「極限作業ロボット」 | その後のテレイグジスタンス | これからのテレイグジスタンス | 参考文献 |

テレイグジスタンスとは [VIDEO]

Susumu Tachi: Telexistence 2nd Edition, World Scientific, ISBN 978-981-4618-06-9, 2015.

テレイグジスタンス (telexistence:遠隔存在) とは、遠隔を意味するtelあるいはteleと、存在を意味するexistenceを合わせた造語で、人間が、自分自身が現存する場所とは異なった場所に実質的に存在し、その場所で自在に行動するという人間の存在拡張の概念であり、また、それを可能とするための技術体系です。厳密には、後述のバーチャルリアリティ(VR)とテレイグジスタンスの三要素を満たすものをいいますが、現存のVRで三要素を満たさないものもVRと呼ばれているように、3条件のすべてを満たさなくとも、テレイグジスタンスを志向しているシステムであれば、それをテレイグジスタンスと呼んでも構いません。

テレイグジスタンスを用いると、自分自身の分身ロボットであるアバターを用いて遠隔の場所に存在したり、コンピュータが創成した身体であるバーチャルヒューマンをアバターとして、コンピュータの創成した情報空間に存在したり、また情報空間を介して、実空間に存在したりすることが可能となります。

つまり、テレイグジスタンスは、人間を従来の時空の制約から開放し、時間と空間ないしはそれらの両者を隔てた環境に実効的に存在することを可能とする。いわば、アバターを利用して人間をユビキタスにすることを可能とする技術です。因みにユビキタス(ubiquitous)とは、「Being or seeming to be everywhere at the same time:同時にいたるところに存在する、あるいはそのようにみえる:遍在する」という意味です。いつでもどこでも簡単にコンピュータを利用できる環境をユビキタス・コンピューティングと呼んだのは、ゼロックス社パロアルト研究所(PARC)のMark Weiserで1993年のことですが、テレイグジスタンスは、コンピュータではなく、実に人間そのものをユビキタスにしようとする考え方なのです。

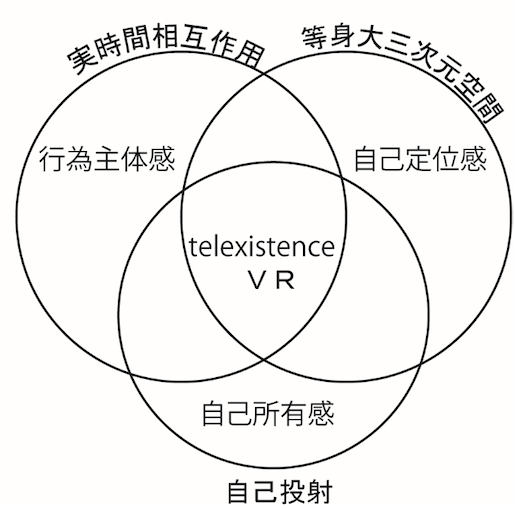

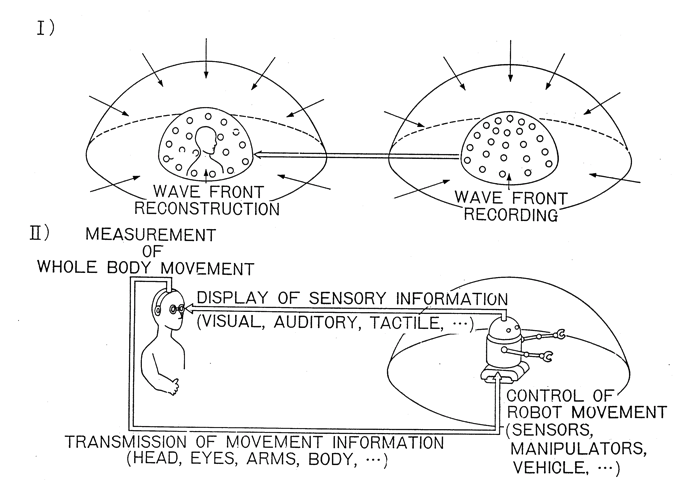

テレイグジスタンスでは、人間が実質的に存在する環境が(1)人間にとって自然な3次元空間を構成しており、(2)人間がそのなかで自由に行動でき、しかもその環境との相互作用が自然な形で実時間に生じ、(3)その環境への自己投射性が生じることが必要です。これらは、バーチャルリアリティの三要素と同一の要素で、それぞれ、等身大の空間性、実時間インタラクション、自己投射性と呼ばれています。

テレイグジスタンスを用いるロボットの制御では、人間の運動や力などが実時間で計測され、内部状態が推定されます。その内部状態がロボットに伝達され、直接ロボットの運動制御システムが制御されるのです。つまり、人の動きを忠実に再現するようにロボットの人工の目、首、手、足などを制御するわけです。その時のロボットの人工の感覚器からの情報は、逆にすべて人間の感覚器にそれぞれ直接提示されることになります。従って、例えば人間が見たい方向を向けば、ロボットも同一方向を向いて、そこに人がいた時に見える情景に対応する像を、人の網膜上に実像として結像するわけです。人が自分の腕を目の前に持ってくると、視野内にはロボットの腕が自分の腕のかわりに全く同一の位置関係で現れてきます。このようにして、人は自分の手と対象物、さらには周りの空間との関係を、自分の過去の経験と同一の関係で捉えて作業ができるのです。ロボットが物体に触れた感覚は、人の手に触覚刺激として提示され、人は自分で直接触れたのに似た感覚をもって作業できます。このようにテレイグジスタンスは、人が遠隔地に実際に存在しているかのような高度の臨場感を持って作業やコミュニケーションを行なうための技術を目指しています。自分の分身のようにロボットを利用する方法が研究されており、医療や宇宙開発、深海調査の分野で実用化が進められている技術です。

一方、バーチャルリアリティ (virtual reality) は、人間が現在実際に存在している現前の環境以外の環境を、あたかもそれが現前の環境のような感覚を持って体験し、かつその環境で行動することを可能とする技術です。そのような観点からすれば、バーチャルリアリティが人間の今いる場所を別の環境に変えるという捉え方をするのに対して、テレイグジスタンスでは、今いる環境以外の別の環境に自分が行くという捉え方をしており、相対的に考えれば、両者は本質的には同一概念のエイリアスであるともいえます。

テレイグジスタンスを用いれば、遠隔のロボットを自分の分身として操り、その眼や耳、体などを用いてロボットの働く環境を臨場感を有して体感し、その環境で自在に行動するばかりではなく、実物の環境ではなくコンピュータの生成した人工環境に入り込み、そこに存在するような感覚を有して人工環境で行動することも可能です。さらにそこにいる実感を持つのに加え、同時に能力の拡張もできます。例えば,人間は暗闇や煙の中では物を見ることができませんが、ロボットの赤外線センサや超音波センサを用いれば暗闇や煙の中でも対象物を捉えることができます。実空間にロボットを使って遠隔臨場しながら、ロボットのセンサ情報や実世界モデルから構成される情報世界を実空間に重畳して利用すれば、暗闇や煙の中でも行動が可能となります。これを、拡張型テレイグジスタンス(augmented telexistence)と呼んでいます。なお、この場合の距離をゼロにしたものが拡張現実(AR :augmented reality)になります。

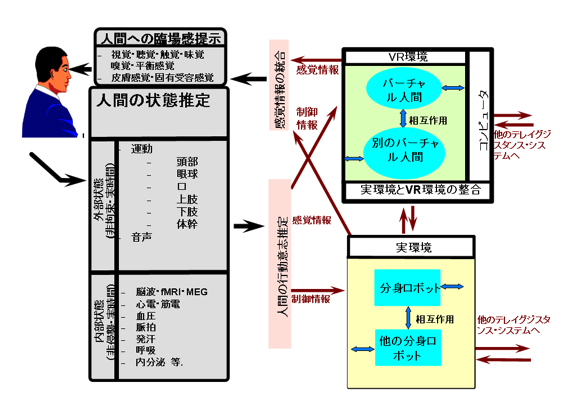

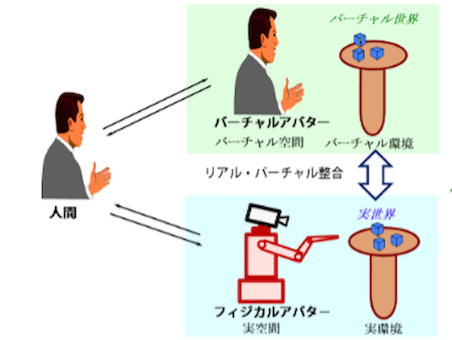

図Aに、こうした実環境、VR環境、及び、VR環境を介した実環境へのテレイグジスタンスの構成を示します。実環境へのテレイグジスタンスであろうがVR環境へのテレイグジスタンスであろうが、人間の側は、全く同じシステムです。人間の状態を推定し、それから人間の行動意思を推定し、それにより、実環境の分身ロボットやVR環境のバーチャル人間を、意の侭に制御します。自分の分身のロボットやバーチャル人間が、実環境やVR環境で行動し、その環境とのインタラクションが生じ、その結果が、分身ロボットの感覚器やバーチャル人間の感覚器を介して受容され、それが、統合され人間の感覚器に臨場的に提示されるわけです。環境には、他のテレイグジスタンスの使用者も参加可能で、そのインタラクションも、相互に伝わる仕組みになっています。さらに、実環境とVR環境の整合を図ることで、例えば暗闇や煙の中でも、明るい場所や煙のない場所のように感じながら行動することも、VR環境を介した実環境へのテレイグジスタンスを行うことで可能となるのです。

図A テレイグジスタンスの構成 [舘 1991]

| テレイグジスタンスとは | テレイグジスタンスの現在 | テレイグジスタンスの社会実装 | テレイグジスタンスとテレプレゼンスの違い |

| テレイグジスタンス黎明期 | テレイグジスタンス発見の瞬間 | テレイグジスタンスはいかにして生まれたか |

| 大型プロジェクト「極限作業ロボット」 | その後のテレイグジスタンス | これからのテレイグジスタンス | 参考文献 |

テレイグジスタンスの現在

テレイグジスタンスの特徴は、人間が新しいロボットの身体(アバター)をもつことにあります。人間は、この新しい身体を自分の身体と同一のものとして自在に行動します。そして、ロボットの眼で見て、ロボットの耳で聞いて、ロボットの肌で感じます。ロボットアバターの中に入っている状態あるいは、ロボットアバターを着込んだ状態が、実際には着込まないでも実現しているのです。

この現在のテレイグジスタンスの解決すべき技術的な課題の一つが、ハプティックテレイグジスタンス(Haptic Telexistence) です。視聴覚については、これまでの研究により、また最近のVRの進展によって、直接その場で見ているのに近い臨場感が得られるに至っています。しかし、触覚については、それには、ほど遠い状況です。現状の技術では、触覚の記録・伝送・提示がアドホックに行なわれており、視覚や聴覚のように人間の生理・心理に基づいた標準化された方式が確立されていないことが、その一因です。

その課題の解決に対する提案が、「触原色」原理です。「触原色」原理は、視覚の三原色が眼球の錐体細胞の波長特性に基づいているのと同様に、触覚の生理学的知見に基づき、対象と人間との接触に際して生じる物理現象を、分解し、伝送し、提示しようとする技術概念です。すなわち、物体の有する凹凸形状、摩擦、熱、弾性といった物理特性をすべて再現するのではなく、その物体との接触によって皮膚表面に生じる、「力」、「振動」、「温度」の三つの物理量を基底として、それらの時間変化を記録し、伝送して、それらの基底を基に触感を合成するのです。

【TELESAR V】

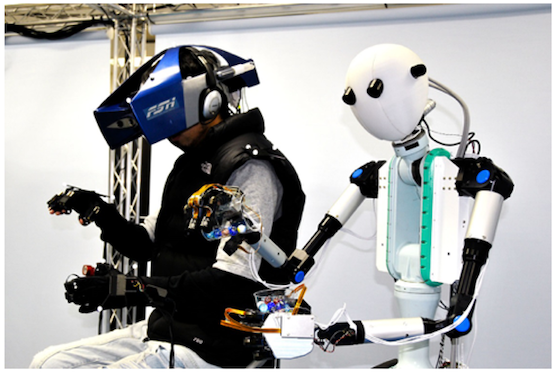

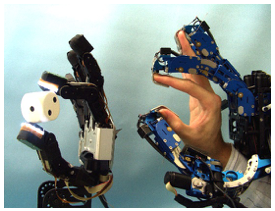

その触原色原理を用いて視聴覚に加え触感をも伝送することが可能となったテレイグジスタンスシステムがTELESAR V です。アバターロボットの指先に搭載し触感を計測する触覚センサと、操縦者の手に装着し手の詳細な運動を計測するとともに触感を提示するグローブ型の触覚ディスプレイを新たに開発しました。触覚センサは、指先と物体との接触力を計測する力センサに加え、広い周波数帯域の振動を計測する振動センサ、および温度センサを内蔵しています。また、触覚ディスプレイは、各要素を指の背や腹に分離して搭載することで、従来難しかった力・振動・温度の3要素の提示を実現しました。これにより、布と紙などの物体表面の細やかな凹凸による触感を伝達できるようになりました。

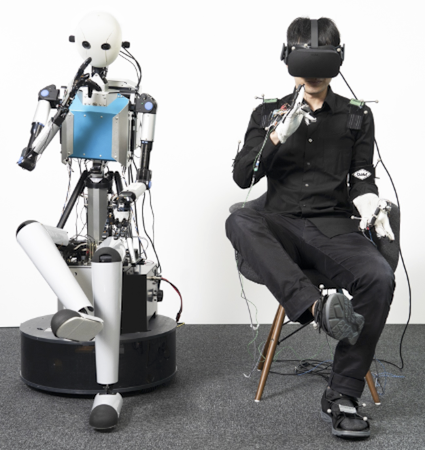

アバターロボットは、人間型のロボットで、首に3自由度、上半身に6自由度、両腕それぞれ7自由度、両手それぞれ15自由度、合計53自由度を有しており、人間の柔軟で複雑な動作に遅れなく正確に追従します。人間とロボットの自由度や大きさの差異は、コンピュータが補正して、それにより自分がロボットの身体をもったような感覚が生まれます[Tachi et al. 2012;Tachi 2015]]。

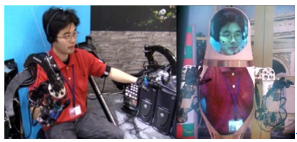

図Bに、このTELESAR V システムの概観を示します。

図B テレイグジスタンスシステム「TELESAR V」:人間(左)とアバターロボット(右)

【TELESAR VI】

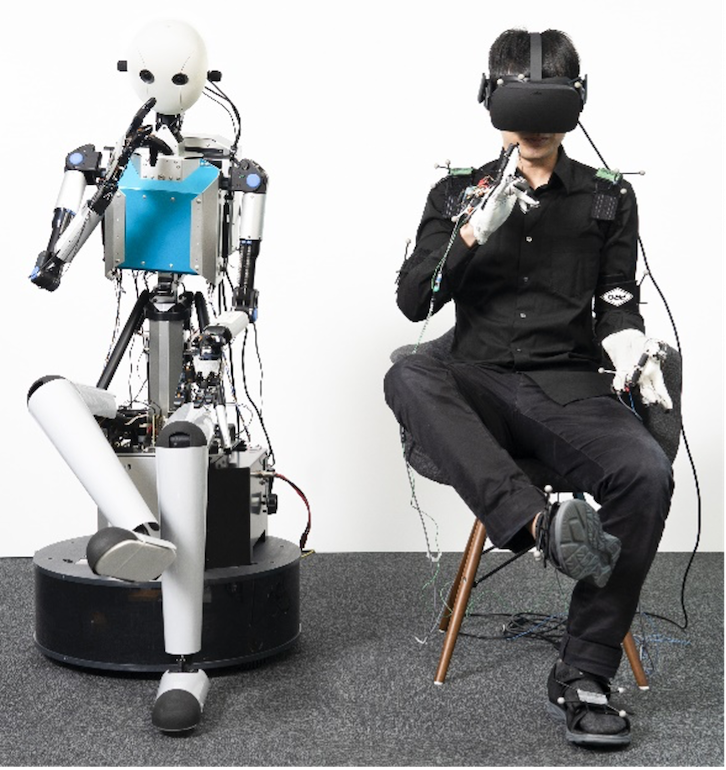

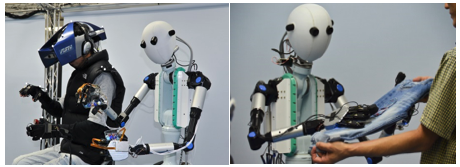

図Cは、JST ACCEL「身体性メディア」プロジェクトで構築した最新のテレイグジスタンスアバターロボット TELESAR VIです[Tachi et al. 2020]。

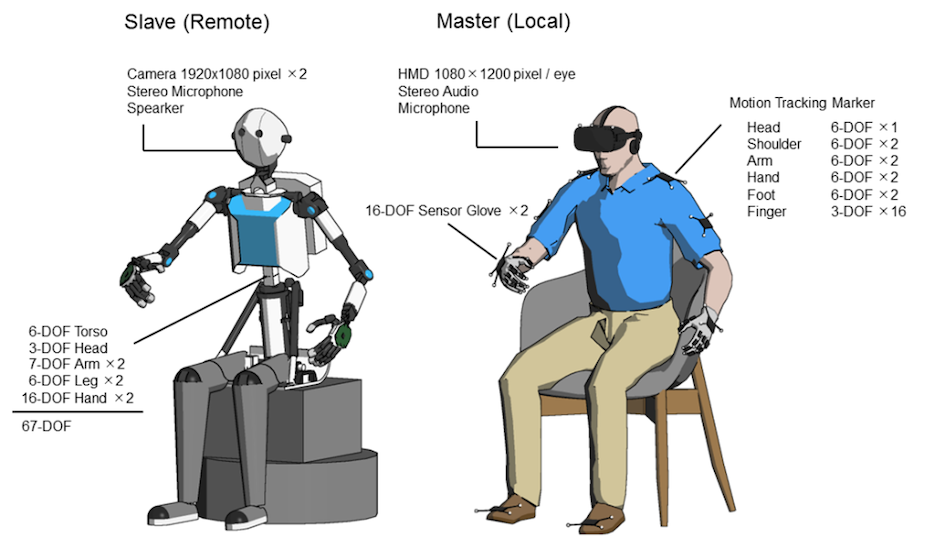

TELESAR VI の特徴は、テレイグジスタンスロボットとしては世界に類いのない頭部3自由度、胴体6自由度、腕左右7自由度ずつ、脚部6自由度ずつ、さらに左右のハンドに16自由度ずつの、都合67自由度を実現したことにあります。TELERSAR VI では、視聴覚の臨場感伝送と人間の134自由度の非拘束な計測を合わせて実現することで AVATAR ロボットの67自由度を制御しての、全身の身体のテレイグジスタンスを可能としています(図C,図D)。人間の自由度により近づいたことで、人間らしい所作が自然に伝えられるようになり、意のままに動く足をもったことにより身体所有感が大幅に増大し、自分が新たなロボットの身体を持ったことがより体感できるようになっているのです。

また、ハンドの制御において,従来の角度のみを伝える方法では人間の手とロボットのハンドの形は似るものの、指先の間隔がずれてしまい作業に支障がでる場合が多々ありましたが、TELESAR VI では、親指と他の指の間のベクトルに注目し、それらをマスターとスレーブで一致させる新しい制御法を考案し導入して前記の問題を解決しています。

さらに、アバターロボットTELESAR VI の10 本の指先すべてに、力センサ,加速度センサ、温度センサを埋め込み、加速度センサ情報を処理することで振動情報を得て、力情報、温度情報とあわせて触3原色としてセンシングする仕組みになっています。これらの情報を指先で束ね、指にそったハーネスで触覚伝送基板に伝え、そこから,Ethernet接続により10本分のデータをまとめて本体のコンピュータに送り、そこから使用者に伝送することができます。

一方、使用者側の触覚の提示システムとしては、使用者の各指に、振動と温度を提示する2原触素子と力提示デバイスを配置して触3原色として提示しています。力提示デバイスは、指パッド、糸、糸通しと小型モータで構成されています。指パッドはモータの力で引っ張られ、最初に指を変形させ皮膚感覚による力感覚が生じ、さらに大きな力で引かれると指関節に力がかかり関節包などの固有受容器による力感覚が生じる仕組みになっています。これにより、触原色原理に基づいた、触覚のセンシング・伝送・提示が10指すべてに可能となりました[Tachi et al. 2020]。

図C テレイグジスタンスアバターロボット TELESAR VI

図D TELESAR VI のシステム構成

【相互テレイグジスタンス】

もう一つの技術的な課題として相互テレイグジスタンスがあります。前述のようにテレイグジスタンスでは、アバターロボットの感覚器を使い、自分がアバターロボットの中に入り込んだような感覚を得ることが可能です。また人間の動きは、アバターロボットの動きとなり、それにより生じた外界とのインタラクションの結果は、人間の感覚器に、あたかも自分が、ロボットの居る環境に身を置いているかのように伝わり、そこでの自在な行動を可能とします。すなわち、臨場感が生じます。

同時に、そのアバターロボットを、そのアバターロボットの周りに居る人が見た時、そのロボットが、そのロボットを使用している人のように見える、あるいは、そのロボットの中に、その人が入っているように見えることが、人との関わりのある場面では大切になります。勿論、声もその人のように聞こえます。動作もその人らしい動作が伝わります。つまり、存在感があるというわけです。

勿論、その人そっくりのロボットを使えば、それらしいことはできますが、しかし、それでは、自分がテレイグジスタンスしたいところにあらかじめロボットを送っておかなければならず用途が限られます。テレイグジスタンスは、世界中にあらかじめ配置されインターネットでつながれているロボットを、皆がシェアして利用して、そこに瞬間移動できる点にも大きな特徴があります。

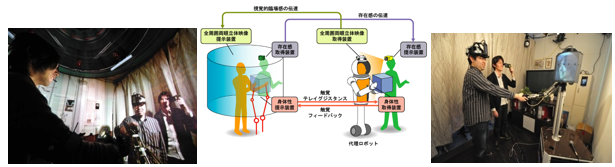

そのようなロボットを使う人を、リアルタイムで見ることができるテレイグジスタンスが、ロボットを用いる相互テレイグジスタンスです。図Eに、そのようなシステムの一例を示します。操作者の姿を、ロボットの頭部や胴体にリアルタイムに投影することで、再帰性投影プロジェクタを覗いた観察者が操作者の表情をロボットの内部に見て、操作者の存在を感じ取ることが可能となります。

光をそれが来たのと全く同じ方向に反射し戻す特性を持つ再帰性反射材をロボットの体表面に塗布することで、ロボットに投影された操作者のリアルタイム映像と、その場に存在するロボットの実像との間に正しく遮蔽関係が構築されるため、例えば操作者の映像の手前にロボットの腕が来た場合には、ロボットの腕が操作者の姿より手前に観察されることになり、操作者の高度な存在感を矛盾無く提示することが可能です。また、ロボットの全面から見れば正面顔が、横から見れば横顔が見える、しかも、周りにいる何人もの人が同時に見ることができるという特徴もあります。

このシステムでは、ロボットの視覚はHMDではなく、マスターコクピット側の多面裸眼立体ディスプレイで操作者に提示されているため、操作者の顔を隠すことなくカメラで撮影でき、そのカメラの映像をスレーブロボット側の再帰性投影プロジェクタでロボット表面に投影することで、操作者の存在感が提示できるのです[Tachi et al. 2008]。

図E TELESAR II : RPTにより相互テレイグジスタンスを可能としている

| テレイグジスタンスとは | テレイグジスタンスの現在 | テレイグジスタンスの社会実装 | テレイグジスタンスとテレプレゼンスの違い |

| テレイグジスタンス黎明期 | テレイグジスタンス発見の瞬間 | テレイグジスタンスはいかにして生まれたか |

| 大型プロジェクト「極限作業ロボット」 | その後のテレイグジスタンス | これからのテレイグジスタンス | 参考文献 |

テレイグジスタンスの社会実装

40年近く長く研究開発段階にあったテレイグジスタンスは、2007年頃からテレプレゼンスという名称で米国に於いて商品化され始めました。ただしこれらは、移動可能なskypeともいうべきもので、コミュニケーションはできるものの臨場感がなく、また作業をすることはできませんでした。そのような状況のなか、世界の偉大なリーダー50人に2014年に選出され、イノベーション界のカリスマと評されるピーター・ディアマンデス氏が1995年に創立した、非営利XPRIZE財団が主催するコンペVisioneers Summit が2016年10月に開催されました。当該Summitの目的は、次のXPRIZEの対象テーマを9つの候補テーマの中から選ぶことにあり、学識経験者や企業のCEO(最高経営責任者)、,VC(ベンチャーキャピタル)の決定権者などからなる約300名のMentorと呼ばれる審査員により、9チームの提案テーマが2日間かけて審査されたのです。

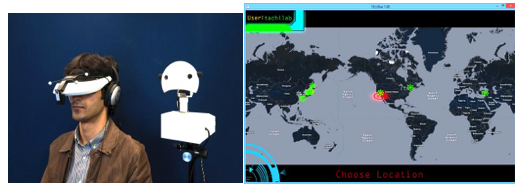

東京大学名誉教授の舘 暲は、 XPRIZE財団のAvatarチームから、『世界で最も進んでいるAvatarであるTELESAR V の実演をVisioneers Summitで行って欲しい』旨の要請を受け、2日間にわたり実演を行いました(図F)。その結果、他のテーマを押しのけ、Avatarが、次期のXPRIZEのテーマとして選定され、世界中からの参加者によるAVATAR XPRIZEに向けての競争が開始されるに至ったのです。

https://www.youtube.com/watch?v=jWNm_vAGr3I

財団はこの競争を通して、時空間瞬間移動産業ともいうべき、VR、ロボティクス,AI、ネットワーク等の最先端のテクノロジーを用い、複数の場所に人間がロボットの身体を用いて存在し物理的な作業までを可能とするテレイグジスタンスの産業化をめざしています。

図F XPRIZE財団の主催するVisioneers SummitでのTELESAR V の実演

この動きに呼応するように2017年には、テレイグジスタンスの産業化を目指す、テレイグジスタンス株式会社などのベンチャ-企業が生まれるに至りました。

https://tachilab.org/jp/about/company.html

2018年になると、KDDI,新日鉄住金ソリューションズとNTTドコモやトヨタなどの大手企業も、臨場感があり作業が可能なテレイグジスタンスを指向した製品をめざしたプロトタイプを公表し始めました。そのような中、いま着実に社会実装が始まっています。コンビニなど社会を支えている社会インフラともいえる業種で、商品検品・陳列業務を遠隔操作化・自動化することで、店舗の省人化を行い、物理的な店舗立地に制約されない自由度の高いスタッフ採用が可能な新しい店舗オペレーションがテレイグジスタンスにより可能になってきています。

その好例が、テレイグジスタンス株式会社が、2020年9月14日に開業した「ローソン Model T 東京ポートシティ竹芝店」でのテレイグジスタンスによる商品陳列作業の実施です。これは、実店舗で実際に導入し運用した最初のものという意味で特筆に値します。アバターロボットModel-Tを店内バックヤードに配置し、本社オフィスなどの遠隔からインターネットを介して陳列作業を行ってます。具体的には、コンビニ業の売上の大きな割合を占めるペットボトル・缶飲料、および弁当・おにぎり・サンドイッチなどの中食を対象とした商品陳列をテレイグジスタンスにて行うというものです。

アバターロボットModel-Tは、コンビニなど狭い小売店舗空間内で商品陳列作業を行えるよう、胴体とアームに22自由度を有しており、ロボットと操縦者間の映像伝送において、ロボット側のカメラから操縦者側のディスプレイに表示されるまでのEnd-to-End遅延として50msを実現しており、これにより視覚と身体感覚との操作のずれをほぼ感じることがなくなり、動きの速い対象物に対して正確な操作や身体的直感に即した操作が可能となっています(図G)。

また、遠隔操作中の商品のピッキング、設置などのオペレーターとロボットの動きのデータを蓄積し、人工知能(AI)に学習させることで,遠隔操作によらず自動で制御・処理する割合を増やす自動化の研究開発も合わせ進めています。なおこれは、NEDO(新エネルギー・産業技術総合開発機構)のConnected Industries推進のための協調領域データ共有・AIシステム開発促進事業の枠組みで行われています。

図G テレイグジスタンスアバターロボットによるローソンの実店舗における商品の通常陳列作業 https://youtu.be/WLDucRUwJbo

将来は、どこからでも店舗スタッフがロボットを通じて就労可能な、全く新しい店舗オペレーションが可能となります。人と人との接触を減らすことにより、新型コロナウィルスをはじめとするこれから起こりうる各種の感染症の感染拡大防止にもつながるだけではなく、少子高齢化や就労人口の減少により人手不足に悩む店舗に導入し、高齢者や介護や子育てをしている人、さらには海外からでも就労可能にすることに加え、自動化と組み合わせて一人が複数店舗を担当できるようにするなど、我が国の就労人口減少という社会課題の解決に貢献することになります。

また、AVATAR XPRIZEの影響を受け、我が国の科学技術政策もAVATARを意識し始めています。内閣府が1150億円の基金のもと2020年度から開始するムーンショット型研究開発制度の六つの目標の第一目標として、「人が身体,脳,空間,時間の制約から解放された社会を実現」を掲げ,誰もが多様な社会活動に参画できるサイバネティック・アバター社会とサイバネティック・アバター生活の実現に挑戦します。すなわち「テレイグジスタンス社会の実現」を目指しているのです。

2030 年までに、一つのタスクに対して、1 人で10 体以上のアバターを、アバター1体の場合と同等の速度、精度で操作できる技術を開発し、その運用等に必要な基盤を構築するとともに、望む人は誰でも特定のタスクに対して、身体的能力、認知能力及び知覚能力を強化できる技術を開発し、社会通念を踏まえた新しい生活様式を提案するとしています。そして、 2050 年までに、複数の人が遠隔操作する多数のアバターとロボットを組み合わせることによって、大規模で複雑なタスクを実行するための技術を開発し、その運用等に必要な基盤を構築して、望む人は誰でも身体的能力、認知能力及び知覚能力をトップレベルまで拡張できる技術を開発することにより、社会通念を踏まえた新しい生活様式を普及させるとしています。

世界的にはAVATAR XPRIZE により、そして,国内的にはムーンショット型研究開発が機動力となり、2030年にかけて、環境、距離、年齢、身体能力など様々な制限に関わらず自在に瞬時に移動することを可能とするテレイグジスタンス技術が実用化され、時空間瞬間移動産業が生まれ育ち、遠隔就労やレジャーはもとより、例えば医師、教員、熟練技術者が不足している地域や、人間の立ち入りが困難な災害現場等でのアバターの活用等を通じて、社会課題の解決と経済発展の両立への貢献が期待されます。さらに、30年周期予想から、2050年代に、再び大きなステップアップが生じて、社会が大きく変わり、その時には、本格的なテレイグジスタンス社会が実現されるものと予想されます(舘予想)。

人間に新しい身体を義体として与え、時空の瞬間移動をバーチャル(実質的)に可能とするテレイグジスタンスは、パンデミックや大規模災害などの危機に対応できる強靭な社会の構築に貢献することはもとより、人間がより人間らしく生きてゆくことに於いても、今後大きく貢献してゆくことでしょう。

| テレイグジスタンスとは | テレイグジスタンスの現在 | テレイグジスタンスの社会実装 | テレイグジスタンスとテレプレゼンスの違い |

| テレイグジスタンス黎明期 | テレイグジスタンス発見の瞬間 | テレイグジスタンスはいかにして生まれたか |

| 大型プロジェクト「極限作業ロボット」 | その後のテレイグジスタンス | これからのテレイグジスタンス | 参考文献 |

テレイグジスタンスとテレプレゼンスの違い

そもそもの概念としてはテレイグジスタンスもテレプレゼンスもほぼ同様の概念の提唱です。異なる点は、テレイグジスタンスは、1)実空間へのテレイグジスタンスに加えてコンピュータの生成したバーチャル空間へのテレイグジスタンス、更にバーチャル空間を介した実空間へのテレイグジスタンスを包括した概念であること、2)自立性との両立を当初から考慮していること、加えて、3)テレイグジスタンスのための3要件が明示されていることです。一方、テレプレゼンスには、それらの概念がありません。また、近年、売られているテレプレゼンスという名の商品では、存在感に重きがおかれ臨場感がない製品が大半です。

1)テレイグジスタンスが、リアルとバーチャルを統合した概念であることについては、VRの創始者と言われているJaron Lanier が、最近の著書(Jaron Lanier: Dawn of the new everything, pp.238, Vintage, Penguin Random House UK, 2018.)のなかで下記の様に、テレイグジスタンスはテレプレゼンスとVRを包括する用語であると述べています。

“Telepresence” used to mean being connected with a robot is such a way that you felt as though you were the robot, or at least that you were in the robot’s location. The community that studied telepresence had started way back in the analog era, well before Ivan Sutherland, or even Alan Turing. Lately it has a broader usage, including Skype-like interactions in VR or mixed reality.

“Tele-existence” was coined by the wonderful pioneering Japanese VR researcher Susumu Tachi to include telepresence and VR.

すなわち、テレイグジスタンス(telexistence,遠隔存在)とは,人間が物理的に存在する場所とは異なる場所で実質的に存在し,そこで自在に行動するという存在拡張の概念であり,それを可能にする技術体系のことも指します。自分自身が物理的に存在する場所と異なった場所は,実空間でも,コンピュータが生成したバーチャル空間でもよく,後者の場合,すなわちバーチャル空間へのテレイグジスタンスは,バーチャルリアリティ(VR: virtual reality)と呼ばれています。さらに,実空間とバーチャル空間を整合することで,バーチャル空間を介して実空間にテレイグジスタンスしたり,実空間にバーチャル空間の情報を付加して行動したりすることも可能になります(図1)。

図1 バーチャル空間へのテレイグジスタンス,実空間へのテレイグジスタンス,及びバーチャル空間と実空間を併せ活用する拡張テレイグジスタンス

2)さらに、自律ロボットをテレイグジスタンスする対象としている点も重要です。下記に示すように、自律ロボットを群として管理し、自律ロボットへのテレイグジスタンスを究極の目標としています。

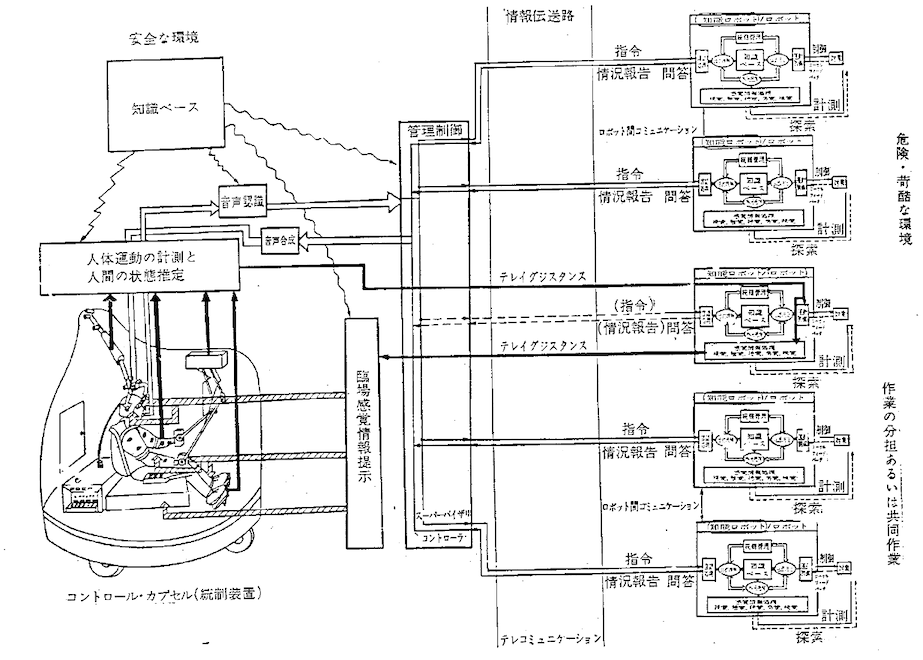

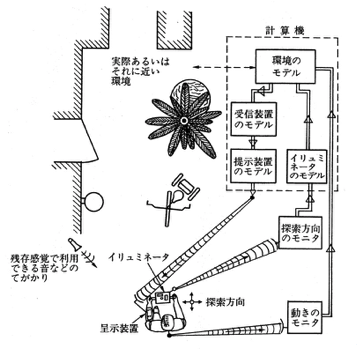

テレイグジスタンス(telexistence)の概念が生まれたのは,1980年9月19日ですが,テレイグジスタンスの概念が,まとまったかたちで学会誌に公表されたのは,1982年12月に発刊された『計測と制御』に掲載された「第三世代ロボット」の論文中です。その中で、図1に示す人間・ロボットシステムとして提案されています。

舘 暲, 小森谷 清: 第3世代ロボット, 計測自動制御学会誌 計測と制御, Vol.21, No.12, pp.1140-1146 (1982.12)[PDF]

以下に,その論文から提案システムと説明を引用します。

[引用はじめ]

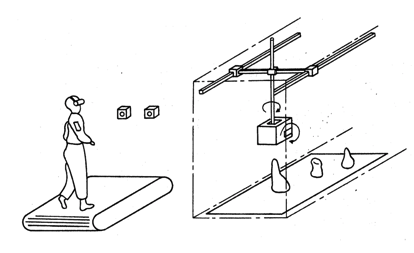

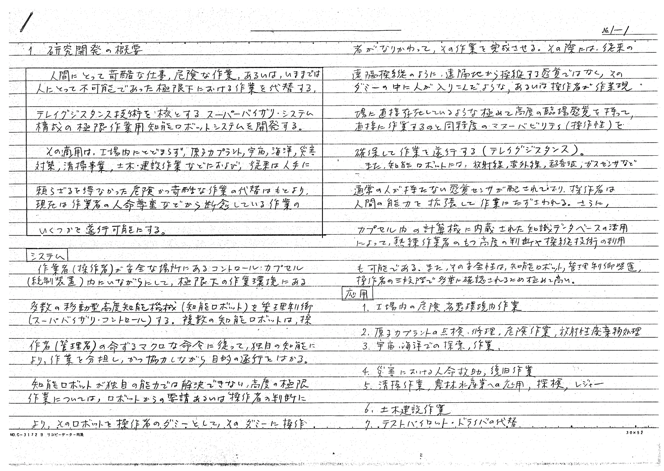

数台の自立移動型知能ロボットがコントロールカプセル(統制装置)内の操作者(管理者)の命令に従って,危険かっ苛酷な作業環境内で作業を分担し,かっ必要に応じて共同しながら働いている.その作業分担やプラニングスケジューリングは管理制御装置(一種のスーパパイザリコントローラ)が受持ち,各知能ロボットからは,仕事の進行ぶりに関する報告が逐次送られてくる.それらはスーパパイザリコントローラで整理され,たとえば音声(視覚・触覚でも可)で操作者に伝わる.操作者は,自然言語に近い言語で命令を下し,判断結果を伝えれば,音声認識装置,スーパパイザリコントローラを経て各知能ロボットへの命令として伝達され,知能ロボットは目的を理解して自らの知能や知識を活用して目的の逐行をはかる.ロボットの感党器の情報はロボットの知的動作のための重要な情報源であるが,それらは操作者によっても随時モニタされている.

安全性からのチェックも知能ロボット自体,スーパパイザリコントローラレベル,操作者といった三段階で行っており,その意味で安全性が高められている.

知能ロボットが,独自の能力では対処しえない困難な作業に直面したとき,ロボットからの要請あるいは操作者の判断で,そのロボットを遠隔操縦モードに切りかえる.その際にも従来のいわゆる遠隔操縦の方式ではなく操作者がそのロボットの中に入って操縦しているような高度の遠隔臨場感(tele-presence) と自分の腕を操るに似た高い操作性(tele-operator) をもって作業のできるテレイグジスクンス(tele-existence) の方式を採用する.その際,知能ロボットの各サブシステムは人の指令によって自由に制御される操縦型ロボットとして働く.

図2 人間・ロボット・テレイグジスタンスシステム

テレイグジスタンスでは,操作者の人体運動や力の状態などが実時間で計測され,操作者の内部状態が推定される.その内部状態がロボットに伝送され,直接ロボットの運動制御回路をコントロールする(図中では第3番目のロボットがテレイグジスタンスモードで制御されており,太線が人とロボットの聞の情報の流れを示している).人の動きを忠実に再現してロボットの人工の目,首,手,足などが制御される.そのときのロボットの人工の感覚器からの情報はすべて対応する人間の感覚器に直接提示の方式で送られる.たとえば,操作者が見たい方向を向けば,ロボットも同一方向を向いて,そこに人がいたときに見える状景に対応する像を人の網膜上に実像として結像する.操作者が腕を目の前にもってくると,視野内にはロボットの手が同じ位置関係であらわれてくる.したがって人は自分の手と対象物,さらには囲りの空間との関係を,自分の過去の経験と同ーの関係でとらえて作業ができる.ロボットが物体にふれた感覚は,人の手に皮膚刺激として提示され,操作者は自分でふれたのに似た感覚を有して作業が行え,理想的には人が直接作業するのと同程度の,現実的には人がロボットの中に入り込んで作業するのと同程度の操作性をもって,人の器用さを生かした作業が逐行できる.

ロボットがもつ,紫外線,赤外線,マイクロ波,超音波,超低周波などのセンサ情報(超感覚情報と呼ぶ)も,操作者がたとえば,夜間は赤外センサ情報を可視光に変換して提示して闇の中で物を見たり,超音波情報を可聴周波数に変換して通常は聞えない情報を操作者が利用したりできる.また,通常の視覚ディスプレイ上に超感覚情報をスーパーインポーズしたり,通常利用しない皮膚感覚チャネルを利用して提示できる.それらの情報を有効利用して操作者は人間能力の拡張をはかれる.また,ロボットの腕の操作性を高めて自分の腕のように制御すれば,通常もてない物がもてるという意味での人力増幅機が実現されることになる.

さらに,カプセル内の知識ベースをたとえば, MITのMedia Roomのようにアクセサビリテイの高い方式で利用することにより操作者の判断がより確実なものとなろう.知識ベースを人の記憶の補助や計算の補助として使う以外に,人の動きをそのままロボットに送るのではなく,熟練作業者の動きに修正して送ることなども興味がある課題である.

これらのシステム技術は,工場やプラント,コンビナート内の危険,劣悪環境内作業,原子カプラントの点検,修理,危険作業,放射線廃棄物処理,宇宙海洋での探索,修理,組立作業,災害時における捜索,人命救助,復旧作業,通常時においては,清掃事業,土木建築作業,農林水産業,警察,探険,レジャー,テストパイロットやテストドライパーの代替なの応用の可能性をもつ根幹技術である.

[引用おわり]

また、下記論文のp.246にテレイグジスタンスが対象とするロボットは究極的には複数台の知能移動ロボットであることが記載されています。

S. Tachi, K. Tanie, K. Komoriya and M. Kaneko: Tele-existence (I) :Design and Evaluation of a Visual Display with Sensation of Presence, Proceedings of RoManSy'84 The Fifth CISM-IFToMM Symposium, pp. 245-254, Udine, Italy (1984.6) [PDF]

The final version of the tele-existence system will consist of intelligent mobile robots, their supervisory subsystem, a remote-presence subsystem and a sensory augmentation subsystem, which allows an operator to use robot's ultrasonic, infrared and other, otherwise invisible, sensory information with the computer-graphics-generated pseudorealistic sensation of presence. In the remote-presence subsystem realistic visual, auditory, tactile, kinesthetic and vibratory displays must be realized.

3)テレイグジスタンスは、バーチャルリアリティとテレイグジスタンスの3要素を有するシステム、あるいはそれを志向しているシステムです。

バーチャルリアリティとテレイグジスタンスの3要素とは、コンピュータの生成する人工環境あるいは、遠隔の実環境であっても、 ① その環境が人間にとって自然な三次元空間を構成しており、② 人聞がその中で、その環境との実時間の相互作用をしながら自由に行動でき、③ その環境と使用している人間と環境とがシームレスになっていて環境に入り込んだ状態が作られているということです。これらをそれぞれ「三次元の空間性」「実時間の相互作用性」「自己投射性」と呼び、この3要素すべてを兼ね備えたものが、理想的なバーチャルリアリティシステムあるいはテレイグジスタンスシステムです(図3)。

図3バーチャルリアリティとテレイグジスタンスの3要素

この3要素はシステムとしての要件を表現しているが、使う側の人間の立場に立った要件に読み替えると、 自己定位感(self-location)、行為主体感(agency)、身体所有感(ownership)の3要件になります。

自己定位感とは、その人が今位置している新たな場所に明確に存在していると認知することです。自己の位置定位による位置認識は一人称視点の視覚が支配的です。テレイグジスタンスでは、代理ロボットの視点からの映像を使用者の頭部運動に連動させ、使用者に違和感のない一人称視点の提示を行っています(等身大三次元空間)。行為主体感とは、ある身体の運動、およびその運動によってなされた行為が、自分自身によって行われているという感覚です。すなわち、この感覚を得るには「自身の行為による結果予測」と「実際にその行為をしたことによる結果」とが合致している必要があります。テレイグジスタンスでは、使用者に代理ロボットを時間遅れや位置ずれを感じさせずに追従させています(実時間相互作用)。身体所有感とは、己の身体が自己のものであるという感覚であり、ラバーハンド錯覚(Rubber Hand Illusion)はこの感覚に関する錯覚現象です。身体所有感を生じさせるためには、使用者の物理的な身体とアバターとなる代理ロボットの身体間の身体図式を一致させる必要があります。テレイグジスタンスでは、使用者が代理ロボットへの身体所有感を感じるように、視覚と深部感覚等の自己受容感覚で得られる情報とに矛盾を感じない工夫がされています(自己投射)。

自己の位置定位、行為主体感、自己所有感は、VRでも担保しなければならない重要な要件です。これらの3要件を担保することで、バーチャルアバターやアバターロボットを自分の新しい身体として感じ、VR空間や遠隔環境で、その身体を自分の新しい身体としての行動が可能となります。

テレイグジスタンスでは、それらに加えて、アバターロボットを自分の身体として行動しつつ、その状態で自分自身を見たときに、いわゆる幽体離脱感覚あるいは体外離脱感覚(out-of-body sensation)が生じます。これはVRにはないテレイグジスタンス特有の現象です。

| テレイグジスタンスとは | テレイグジスタンスの現在 | テレイグジスタンスの社会実装 | テレイグジスタンスとテレプレゼンスの違い |

| テレイグジスタンス黎明期 | テレイグジスタンス発見の瞬間 | テレイグジスタンスはいかにして生まれたか |

| 大型プロジェクト「極限作業ロボット」 | その後のテレイグジスタンス | これからのテレイグジスタンス | 参考文献 |

テレイグジスタンス黎明期

1980年テレイグジスタンスの概念の提唱:1980年9月19日にテレイグジスタンス(telexistence=tel-existence:tel=離れて+existence=存在)に思い至る[Scoică 2015]。図1にテレイグジスタンスの概念図を示します。

図1 テレイグジスタンスの概念 [舘 1982]

1982年テレイグジスタンス立体視システム:操作者の頭の動きどおりに動き、カメラの映像を操作者に提示するシステムを開発しました。81年の試作当初は視覚だけの装置でした。人間が直接見たときの網膜像と等価になるように設計した立体提示装置が完成したのは81年末で、82年に計測自動制御学会大会論文集に論文が掲載されます。これを実験し体験したのは81年の末から82年の初めでした。このシステムで自分自身を見たときの驚きは今も忘れられません。いわば、初めての幽体離脱ともいうべき体験でした(図2)。自分自身があたかも幽体離脱したかのように三次元世界に存在し、しかも手を上げたり下げたりしている自分の姿がリアルタイムに観測されたのです。その装置により見えた世界は白黒の世界ではあったのですが、自分自身が自分自身を客体的に観測しているありさまに大変感激しました。一生忘れられない感動でありました。他の体験者も、カメラロボットがあたかも自分の頭であるかのように「テレイグジスタンス」できたとの報告をしています。さらに、このような主観的な評価にとどまらず、客観的に直接視と同等であることを、ホロプタを用いる心理物理実験で示しました[舘、荒井 1989]。

図2 テレイグジスタンスで自分をみる

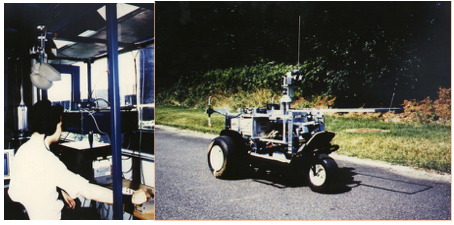

1985年テレイグジスタンスビークルの開発:遠隔からでも、あたかも移動ロボットに乗り込んだような感覚で移動制御できるテレイグジスタンスシステムを開発。自分が車の運転手になった感覚で移動し障害物を回避できました(図3)。

図3 移動ロボットへのテレイグジスタンス

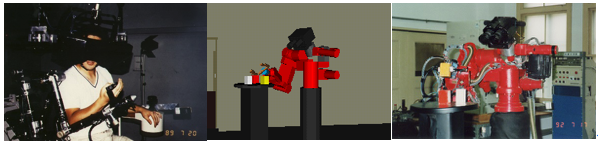

1989年TELESARの開発:ロボットの中に入り込んだような臨場感覚を得ながら、ロボットを自分の分身のように自在に制御できる人間型ロボット TELESAR (Telexistence Surrogate Anthropomorphic Robot) を開発。ブロックを積んだり、卓球の球を打ったりする作業が自分で直接行っている感覚で行えることが確かめられました[Tachi and Yasuda 1994]。また、実空間に加えてバーチャル空間へのテレイグジスタンスも可能となりました(図4)。

図4 人間型ロボットTELESARへのテレイグジスタンス

| テレイグジスタンスとは | テレイグジスタンスの現在 | テレイグジスタンスの社会実装 | テレイグジスタンスとテレプレゼンスの違い |

| テレイグジスタンス黎明期 | テレイグジスタンス発見の瞬間 | テレイグジスタンスはいかにして生まれたか |

| 大型プロジェクト「極限作業ロボット」 | その後のテレイグジスタンス | これからのテレイグジスタンス | 参考文献 |

テレイグジスタンス発見の瞬間

(バーチャル・テック・ラボ p.102 より[舘、廣瀬 1992])

そもそもの始まりは客員科学者として滞在した MITでの研究生活を終え、筑波の研究所に戻ってきた1980年の夏であった。日本で生まれた世界初の盲導犬ロボットの研究はまさに大詰めを迎え、 MITでの成果を盛り込みつつ心血を注いでいた。 MITでは、ボストンアームで高名なマン教授とともに模擬装置を利用する盲人の歩行補助装置の系統的かつ定量的な評価方法を提唱し研究を行った。

その MITでの研究と日本での盲導犬ロボットの研究の新たな展開としてテレイグジスタンスに思い至ったのは、その年の初秋のある日の朝、研究所の廊下でのことだった。所詮人間の視覚は波動に基づいており、結局二つの目の網膜に映し出された2枚の映像だけしか人間は利用していない。ただ、時々刻々の変化を能動的に捉えそれから三次元を再構成しているのだという事実を再発見した瞬間だった。

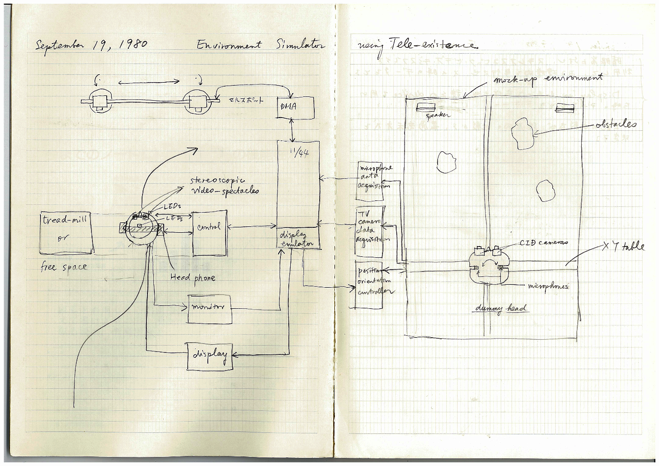

直接視で得られるのと同一の網膜像を計測と制御の力で人間に与え続ければよい。その瞬間それまでのもやもやが、一瞬のうちに霧散するのを感じて軽い身震いさえ覚えた。すぐ研究室に戻りノートに向かって溢れるように浮んでくる考えを次々とまとめていった(図5)。驚くべきことではあるが、視覚提示の原理も同時にいわば大悟した。

テレイグジスタンスに思い至って世界に対する見方が一変した。テレイグジスタンスと人工現実感は人間の時空の制約を解放するであろう。存在とか現実とかの本質に迫るということもあながち絵空事でもあるまい。

図5 テレイグジスタンス発見時のアイディアのスケッチ(1989年9月19日)

| テレイグジスタンスとは | テレイグジスタンスの現在 | テレイグジスタンスの社会実装 | テレイグジスタンスとテレプレゼンス |

| テレイグジスタンス黎明期 | テレイグジスタンス発見の瞬間 | テレイグジスタンスはいかにして生まれたか |

| 大型プロジェクト「極限作業ロボット」 | その後のテレイグジスタンス | これからのテレイグジスタンス | 参考文献 |

テレイグジスタンスはいかにして生まれたか

(人工現実感 pp.148-155より [舘 1992] )

テレイグジスタンスは日本で独自に考えだされたのだが、どうしてそのような概念が生まれたかということを紹介してみたいと思う。

もともと、私は「盲導犬ロボット」という研究をしていた。首導犬ロボットとは、目の不自由な人の補助をすることを目的として作られて研究されたものである。ロボットによって環境を認識してその情報を人間に伝えながら、目の不自由な人の歩行を手助けするシステムだ。その盲導犬ロボットの研究で、盲導犬ロボットのような補助的な装置が環境情報を得たときに、その情報をどのように人間に提示すれば人間はそれを使って歩行できるか、という問題が発生してきた。

また次のような問題も重要になった。たとえば3メートル先の左側に自動車が駐車してあるとか、あるいは人が1メートル前方を同じ方向に歩いているとか、十字路が10メートル先にある、などという情報を盲導犬ロボットなどの歩行補助装置が人間にどう教えるかという問題である。それらの情報を音や皮膚刺激などの不自由な人の残存感覚を介して、適切に伝えなくてはならない。そういった伝達方法がいわゆる目の不自由な人のための、補助器の設計法になる。別の言い方をすれば、どういう情報をどのように教えると人間が自由に歩けるかということを知りたいわけである。ところが、その方法が確立されていなかった。情報をどう伝えれば人間が歩きやすいか、それを調べることさえ難しかったのである。

当時の装置というのは、全て「こんなふうにするといいかな」とだれかが考えついて、その考えついたアイディアを利用して装置を設計し、使ってみて具合が悪いと直すということを繰り返していた。そのような方法だと、設計してから作って、作ったものを利用してみて、また作りなおすという繰り返しで時間がかかる。またそのできた装置が、評価をした人には使いやすくても、別の人が使おうと思うとうまく使えなかったりする。そこで、もっと組織的に万人に使いやすい装置を設計すると同時に、実際には使用者一人一人に適した装置を作るという必要がある。ところが、実際のものを作ってこのようなプロセスを踏むのでは時間的や経済的な面だけでなく、設計開発を行う方法論すらなく、言うは易いが、行おうとすると、とてもできないという現実がある。

そこでそれを解決するひとつの方法として考え出されたのが、コンピュータを使って人間に歩行のための情報を伝達するシステムを作って、それによって擬似的に人に歩行情報を系統的に変えながら提示して、その評価を行おうという考え方であった。ロバート・W・マン教授という、ボストンアームという世界で初めて実用化された筋電制御型の義手を開発した高名な先生が、MIT(マサチューセッツ工科大学)にいた。私は1979年から80年にかけてMITでマン教授と一緒に研究をしていた。その研究は次のような考え方に基づいていたのである。

これは、「基本的には装置を実際に作るわけではなくて、仮想的に伝達方式を作ってそれによって情報を人間に伝える。それで個人への最適化もするし、みんなに使いやすい装置に仕上げることも行えるようにする研究」であった。もう少し詳しく説明すると、MIT時代に考えていたのは次のようなことである。補助装置を使って実際と同じような実物大の模型の空間を人が歩く。その時の人の運動を計測する。補助装置はコンピュータでシミュレーシヨンして、人間の動きから、いまどのような環境の情報を補助装置が得ているかを計算する。そして、その情報を、考えられるさまざまな方法で人に伝える。その伝え方を変えてみてその時の人の歩行の方法を測定する。それを系統的に繰り返すことにより、どのような情報をどのように人に与えれば人が歩きやすいかが、人の歩行の仕方を評価することにより定量的にわかってくるわけである(図6)。

図6 人間・装置・環境シミュレータ

1980年の夏に帰国して、それをもう少し発展させてみた。この方法は画期的な方法ではあるが、しかし短所もある。つまり実際の空間を歩けば、物にぶつかったときには危ない。それに実際の空間というのはなかなか変えられない。そうすると、一回動いてしまうと同じ空間なら、今度は補助装置がなくても歩けてしまうわけである。

それではいけない。いろいろと空間の方も自由に変えながらもしっかりと補助装置の評価をしたい。そこで、コンピュータのようなもので空間を自由に変える必要がでてきた。このようなことがひとつの発想となって、コンピュータでバーチャル空間を作って、そこを歩きまわるというようなことを考え出したわけである。しかし、その当時は、バーチャルリアリティという言葉も生まれる前であり、コンピュータで補助装置も空間も全部作り出すのは、たいへんだった。

そこでその次の段階として考えたのが、コンピュータで全部作るのではなく、空間は実際に作るけれども、人間が歩くと危ないのでロボットにその中を歩かせる。そして、自分は安全なところで歩いてその人間の動きをロボットに全部伝えて、そのロボットを動かす。そしてそれを使って評価すれば、何かにぶつかって危ないというようなことは人間自身には起こらないし、自分がここにいながらにして向こうにいるロボットのところに自分がいるような感覚で歩ける。さらにこの方法の良い点は、目の不自由な人だけではなくて目が見える人がどう歩いているかというようなことの研究にも発展させられる点であった。

つまり、ロボットに視覚を与えて歩かせる。目の見える人でもロボットの方の視覚をずっと悪くしてくると、だんだん見えなくなってくる。そうするとその動き方がどう変わるか。そのときにどういう情報を抽出して人間に与えれば人間がうまく歩けるか。そういう研究が可能になると考えて装置を考案した。それを「盲人用歩行補助器評価装置」の特許として提案したわけである(図7)。

図7 盲人用歩行補助器評価装置(1980.12.26出願)

科学技術庁長官選定第42回注目発明(1983.4.18)

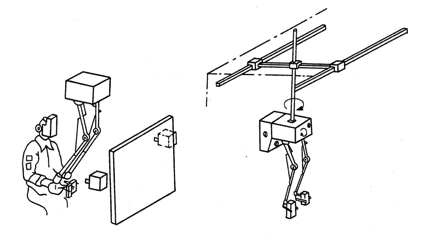

それと同時に、このようにロボットを別の空間で動かすということは、自分の代わりであるロボットを用いていろいろな作業ができるのではないかと発想した。われわれのところはもともとロボットを研究しているグループであり、ずっと以前からテレオペレーションを熟知していた。この技術を使うと、それまでテレオペレーションとして考えられていたものが、新しいステップを昇るわけである。この方法ならば、今までのテレオペレーションとは違ってオペレータがあたかもロボットのいる場所にいるような感覚で作業ができて、能率的にそして飛躍的に作業が進展するということに思い至った次第である。それが1980年の暮れぐらい。そのようにしてマニピュレーシヨンに関する「感覚情報呈示機能をもったマニピュレータの操縦方法」の特許が生まれたのである(図8)。

図8 感覚情報呈示機能をもったマニピュレータ(1981.1.11出願)

以上のような経緯があって、「テレイグジスタンス」という概念が生まれたのである。しかも、それがちょうど極限作業ロボットという1983年からスタートするプロジェクトとあいまった。極限作業ロボットのプロジェクトを興すための準備が進むうちに、「テレイグジスタンス」が非常に重要なテクノロジーだというように通産省の機械情報産業局でも認識され、それが極限作業ロボットのひとつの中核技術として認められ、育っていったわけである。もっとも逆に、ひとつのキーテクノロジーとしての「テレイグイズタンス」を中心として大型プロジェクト「極限作業ロボット」が起きたということもいえる。因みに最初の学会発表は1982年の7月に開催された計測自動制御学会の学術講演会で行われた。この時に世界で初めて「テレイグジスタンス」という概念が学問の世界に登場したのである。

このような経緯からもわかるように、アメリカの「テレプレゼンス」とはまったく独立の流れとして「テレイグジスタンス」が生まれたわけである。アメリカでも同じようなころに、宇宙開発を中心としてミンスキーなどがアイディアを出して、「テレプレゼンス」が育っていったのは歴史の偶然とはいえ、おもしろいことである。やはり技術はそれが生まれ育つタイミングというものも内包しているのかもしれない。

| テレイグジスタンスとは | テレイグジスタンスの現在 | テレイグジスタンスの社会実装 | テレイグジスタンスとテレプレゼンスの違い |

| テレイグジスタンス黎明期 | テレイグジスタンス発見の瞬間 | テレイグジスタンスはいかにして生まれたか |

| 大型プロジェクト「極限作業ロボット」 | その後のテレイグジスタンス | これからのテレイグジスタンス | 参考文献 |

大型プロジェクト「極限作業ロボット」

ちょうどそのころ通産省で大型プロジェクトを模索していました。1960年にエンゲルバーガーが「ユニメート」というロボットをつくり黎明期を拓いてから20年たった1980年はまさにロボット元年とも称され、日本はロボット王国とまでいわれていたのです。しかし、80年に活躍していたロボットは、いわゆる第一世代のプレーバック・ロボットで、工場内に第二世代のロボットが少し出てきたというような状況でした。私がテレイグジスタンスを研究しているのを知って、話をして欲しいと、さる通産省の課長補佐の上原氏から依頼されました。私がいろいろな構想を述べると、それをまとめて直ぐに通産省に持参するようにいわれ、休みを返上して提案書(図9)を書きました。この提案書がもとになって、1983年に「極限作業ロボット」のプロジェクトが発足したのです。

図9 大型プロジェクト「極限作業ロボット」の提案書

「極限作業ロボット」の開発官室ができて最初の1年はそこに併任しました。「極限作業ロボット」は、原子力や海洋、石油コンビナートなどで使われます。特に重要だったのが脚式です。それまでの車輪型ではなく脚式のロボットでないと、パイプをまたいだり階段を昇り降りしたりができないからです。動き回りながら作業するためのアームだけでなくハンドが必要であり、もちろん三次元の視覚や触覚もいります。そういった研究を行って、自律的なロボットを作るというのです。

しかし、自律的なロボットが作業できるのは構造化された既知の環境だけであり、極限作業環境のように構造化されていない環境では、スーパーバイザリ・コントロールが必要になります。ところがスーパーバイザリ・コントロールにも限界があり、やはり人が直接行わなければいけない局面が現れます。しかし、「極限作業ロボット」の働く環境は、危険な場所だったり遠く離れていたりするので、すぐには人が行けません。まさにテレイグジスタンスを有効に使える場面なのです。こういう枠組みを「第三世代の枠組み」とよびました。つまり、第三世代のロボットです。

その間も研究所に戻って、テレイグジスタンスの研究を続けました。すると、前述のようにアメリカでもテレイグジスタンスの考えが出てきたのです。「テレプレゼンス」です。人工知能の大御所マービン・ミンスキーが、その概念を宇宙開発にあわせて提案しました。1983年のことです。テレプレゼンスの概念は、ARAMIS報告書として提出された1983年よりもさらに早く1980年にでていたということなので、日米同時に概念が生まれたといえます。そして、実際にものをつくって実証したのは私が世界で一番早かったことになります。テレイグジスタンスはそれほど画期的なものでした。

| テレイグジスタンスとは | テレイグジスタンスの現在 | テレイグジスタンスの社会実装 | テレイグジスタンスとテレプレゼンスの違い |

| テレイグジスタンス黎明期 | テレイグジスタンス発見の瞬間 | テレイグジスタンスはいかにして生まれたか |

| 大型プロジェクト「極限作業ロボット」 | その後のテレイグジスタンス | これからのテレイグジスタンス | 参考文献 |

その後のテレイグジスタンス

1989年になり東京大学に戻って先端科学技術研究センタ-(先端研)で研究をしないかと誘われました。まだプロジェクトが終わっていなかったので、最初は研究所が主で東大のほうが併任、途中から東大が主で研究所が併任となりました。プロジェクトが1991年に終わったあと、テレイグジスタンスの装置も先端研に移ったのです。私は研究所と大学の両方を経験することになったわけですが、基本的には連続的であり大きな違いは感じませんでした。違いを少し感じたのは、大学は教育と研究を、国の研究所は行政と研究をそれぞれその任とするという点です。しかし、研究という面では両方とも一緒でした。研究自体は、勿論自分が興味を持ち情熱を注げるものでなくては、そもそも研究にならないわけですが、しかし国の研究所や国立大学である以上、研究は多くの人のためになるものでなくてはならなりません。多くの人たちがこれは重要だと認める研究をする責務があり、またそのような研究を推進していかなければならないのです。大学に移ってあらためてその思いを強くしたのでした。

さて、1990年になってMITが世界中の研究者に召集をかけました[Tachi 2017]。工学の様々な分野だけでなく、芸術や心理学などバーチャルリアリティとおぼしきものに携わった最先端の研究者を一堂に集めたのです。それがサンタバーバラ会議です。バーチャルリアリティという言葉は1989年に生まれたばかりで、それまでは「サイバースペ-ス」「テレイグジスタンス」「アーティフィシャル・リアリティ」「バーチャル・エンバイロンメント」などいろいろな名前でよばれていました。

サンタバーバラで一堂に介して、それぞれの研究を発表しあい、ディスカッションするなかで、分野は違うもののねらいは同じだということがわかりました。それは何かというと「三次元の空間性」「実時間の相互作用性」「自己投射性」です。そしてこの三つをそなえたものを「バーチャルリアリティ」と統一してよぼうと決めたのです。会議には私もよばれていましたが、私はそのとき、テレイグジスタンスとバーチャルリアリティはある意味では全く同一であると喝破したのです。

そこで同じ年に日本でも人工現実感とテレイグジスタンスの研究会をつくり、翌年国際会議を開催しました。ICAT (International Conference on Artificial Reality and Telexistence) です。 その後1995年に「人工現実感の基礎的研究」が文部省の重点領域研究に認められ、四つの班に分かれて研究を行いました。その成果は、4冊の本として纏められます。こうした領域ができて人工現実感の研究会と一緒になって生まれてきたのが、1996年に発足した「日本バーチャルリアリティ学会(VRSJ)」なのです。

1994年に先端研から工学部の計数工学科に移ったときのことでした。これからのロボットについて話しを伺いたいとのことで通産省の尾崎氏が訪ねてきました。 私は第一世代、第二世代、第三世代の次に、ネットワークとロボットが結びつく時代がくると申しあげた。すでにインターネットを介して、いろいろな情報が自由に行き来しているが、今のネットワ-クではアクションとかビヘイビアは伝わらない。これからの社会では、アクションとかビヘイビアが自由に伝わるようなネットワーク社会が重要となる。このときの会談がもととなり1995年、テレイグジスタンスの考え方にもとづく次世代ロボット構想の「アールキューブ」がまとめられたのです。

この構想は、ネットワークを介して誰でもがリアルタイムにロボットなどさまざまな機器を自由自在に動かすことのできる社会を目指して技術開発を進めようというものでした。つまり、臨場的実時間遠隔制御技術を確立することにより、現在いろいろな情報を自在にやりとりしているのと同様に、人間の行動をも自由自在に伝えていくシステムをつくろうという構想です。それがもとになって、『アールキューブ』という本が書かれました。この構想を一つのビジブルな世界として、それを実現するためにはどうすればよいかが話し合われ、研究計画が進んだのです。その後、1998年にアールキューブ構想の一環として「人間協調共存型ロボット(HRP)」のプロジェクトが5年計画で行われたという経緯があります。

1994年アールキューブ構想:ネットワークを介してテレイグジスタンスを可能とするアールキューブ(R3 : Real-time Remote Robotics)が提唱され、「アールキューブ」構想委員会が通商産業省(現在,経済産業省)により設置されました。また96年、構想をまとめた書籍である『アールキューブ』が出版され、その中で「アールキューブ・ストーリー」というSFで、来るべきアールキューブ社会が描かれています(図10)。

図10 アールキューブ構想

2000年人間協調共存型ロボット(HRP):アールキューブ構想の一環として実施されたHRPプロジェクトにおいて、人間型2足歩行ロボットへのテレイグジスタンスの実装がなされました[Tachi et al. 2003](図11)。

図11 二足歩行ロボットへのテレイグジスタンス

2001年ロボットホンの開発:ロボットを人間に対するインタフェースとして積極的に利用することを提案し、人間のコミュニケーションに使用するロボットホンを開発しました(図12)。

図12 ロボットホンで動作を伝える

2005年TELESARⅡの開発:操作者の「臨場感」に加えて、遠隔地側で操作者の「存在感」を実装する相互テレイグジスタンスの概念を提唱し、実証システムとしてTELESARⅡを開発しました。その人がロボットの中に入っているように見えます[Tachi et al. 2008]。なお、TELESARⅡを用いた相互テレイグジスタンスシステムTELEsarPHONEは、愛・地球博に出展されました(図13)。

図13 臨場感と存在感を伝える相互テレイグジスタンス

2007年TELESAR Ⅲの開発:6自由度の首機構に両眼カメラが取り付けられ回り込みなどの自由な動作が可能となりました(図14)。

図14 回り込みによる臨場感と作業性の向上

2008年 Haptic Telexistence: テレイグジスタンスにおいて触覚が重要であることからGelForceと呼ぶ分布ベクトル力場を計測できる触覚センサを開発し、加えて、その触覚情報を人間に提示するための方法として視覚における三原色と同様の仕組みを触覚にも求める触原色の考えを2002年に提案[舘 2002]、その解明と実現を経皮電気刺激や振動刺激などの研究を通して行い実装しました。また、遭遇型と称する固有受容感覚提示法もあわせ組み込みました(図15)。

図15 触覚を伝えるハプティクテレイグジスタンス

2010年VR空間に集う:TWISTER(Telexistence Wide-angle Immersive STERoscope)という眼鏡なしで360度を立体視可能なシステムを研究開発し、それをブースとして、多人数の人がそれぞれTWISTERを利用し、それぞれが離れたところにいても、あたかも同一場所に参集したのと等価な状態で互いの顔を見ながらコミュニケーションすることを可能とするシステムを研究開発しました[渡邊ほか2012](図16)。

図16 VR空間に集う

2011年 :会場へ遠隔参加するTELESAR IV:TWISTERを用いて、遠隔から例えばパーティ会場に遠隔参加することを可能とするシステムを開発しました。会場に居る人も、遠隔から参加した人の顔を見ながら、また握手をしたりして親交を深められます[舘ほか 2012](図17)。

図17 パーティ会場へ遠隔参加

2012年:細やかな触感を伝えるTELESAR V:53自由度の肢体を駆使した視覚や聴覚の臨場感溢れる伝達に加えて、ロボットが手に取った物の材質や温度などの遠隔環境の細やかな感触を人に伝えることのできる触覚テレイグジスタンスに、2012年7月、世界で初めて成功しました[Tachi et al. 2012]。8月には、米国のSIGGRAPHで展示公開されました(図18)。

図18 細やかな触感の伝達

2013年 :TeluBeeの開発:世界中にロボットを配して、誰でもが自在にどこにでもテレイグジスタンスできる社会を目指して研究を進め、その一環として、家庭でも使える簡易型のテレイグジスタンス視聴覚ロボットを開発しました(図19)。

図19 世界中のロボットに入り込む

2014年:Flying Telexistence:Droneを分身として自由に空中からのテレイグジスタンスを目指すシステムを開発(図20)。

図20 テレイグジスタンスで大空を翔る

2016年:XPRIZE NEXT CHALLENGEに採択される:米国XPRIZE財団が主催する Visioneers Summit にて、ANA Limitless Travel AVTAR の提案に協力し、TELESAR V をデモンストレーションしました。 その結果、AVATAR XPRIZEが、賞金 20億円規模のGlobal Challenge実施テーマとして採択されました https://www.youtube.com/watch?v=jWNm_vAGr3I (図21)。

図21 XPRIZE財団の主催するVisioneers SummitでTELESAR V の実演を行う

2017年:テレイグジスタンス株式会社の設立:2017年1月23日 テレイグジスタンスで未来を創るロボティクス開発ベンチャー「テレイグジスタンス株式会社( TX inc.)」を設立しましたTelexistence: How This Tokyo Startup Is Building Real-Life Avatar Robots (図22)。

図22 2017年5月に事業資金を得て実質的なスタートをきる

2017年:Telexistence Toolkit 完成:テレイグジスタンスを簡易に体験することを目的にテレイグジスタンスツールキットを完成。頭の3軸の運動を伝え、1人称視点の自然な視覚体験が可能です。AR機能で腕や胴体を付与することもできます [井上ほか 2019] (図23)。

図23 簡易にテレイグジスタンスを体験できる

2019年:TELESAR VI 完成:67自由度を有する人間型テレイグジスタンスロボットTELESAR VI を研究開発しました。触原色伝送モジュールの活用、手の運動機能の高度化、脚部の付与などを行っています。1kHzの振動・力、50Hzの温度情報を10本指で同時に計測可能な触覚伝送系を搭載。手のローカル座標系における、母指および母指に対向する各指までの指間ベクトルをマスタスーブ間で一致させるよう制御する方法によりハンドリング操作の高精度化を実現しています [Tachi et al. 2020] (図24)。

図24 頭から足までの全身をテレイグジスタンスするアバターロボット TELESAR VI

| テレイグジスタンスとは | テレイグジスタンスの現在 | テレイグジスタンスの社会実装 | テレイグジスタンスとテレプレゼンスの違い |

| テレイグジスタンス黎明期 | テレイグジスタンス発見の瞬間 | テレイグジスタンスはいかにして生まれたか |

| 大型プロジェクト「極限作業ロボット」 | その後のテレイグジスタンス | これからのテレイグジスタンス | 参考文献 |

これからのテレイグジスタンス[舘 2016]

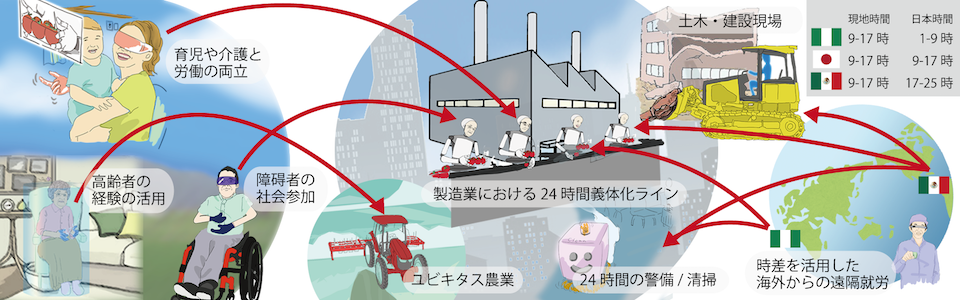

現在我が国をはじめ先進諸国では、大都市への人口の一極集中、高齢者の増加と少子化による働き手の減少、移民による文化摩擦や治安の悪化、子育てと労働の両立、通勤に時間がとられ自分の時間が持てないなど、多くの困難な課題を抱えています。

人の移動の概念を変え、実際的な移動を伴うこと無く身体機能を移動させることができれば、この困難を克服することができます。いままでの遠隔からの在宅勤務は、映像や資料、また会話などを伝える遠隔コミュニケーションに限られ、実際にその場に居ないと行えない工場での労働や建設現場の作業などを在宅で行うことは不可能でした。テレイグジスタンスは、五感のみを伝える遠隔コミュニケーションという従来の範疇を逸脱して、人間の身体機能そのものを伝達してしまう画期的な方法です。

身体機能を移動できるテレイグジスタンス社会が実現すれば、人と産業との関わりや社会のありかたが、根幹から変革します。労働環境の問題が解消され、悪環境で働かなくても済むのです。どんな場所に工場を置いても、仕事をする人を全国、あるいは全世界から集められるため、いままでとは工場の立地条件が革命的にかわり大都市への集中が避けられます。国外の労働者も遠隔から就労できるため、移民問題を解消します。さらに時差を利用することで24時間の労働力を複数の国外拠点から確保でき、どこの国の就労者も夜勤が不要となります。男女問わず育児しながらの労働参加が可能となり、子育てをしやすい社会となります。

グローバルなビジネスにおける移動による時間的コストも解消する。通勤に伴う移動が不要となり、交通問題を緩和できる。職住近接が必ずしも必要ではなくなり、都市への人口集中が緩和され、ワーク・ライフ・バランスを改善し、本人が住みたい場所に住んで、生きがいのある生活を行えるようになると予測されます。

また義体である分身ロボットにより身体機能を補綴・拡張することで、高齢者や障碍者でも若者に体力的に負けず、豊富な経験を活かした労働参加が可能となり労働の質が格段に向上し日本の活力がよみがえることが期待できます。世界的に一流のスキルを有する技術者・医師等の専門家の招聘も容易になり、職能に応じた人材の最適配置が行えるのです。

将来的には、災害時や非常時の緊急対応を安全な場所から瞬時に行うとともに、常時には、医療や介護、また医師や専門家の過疎地への派遣が行えます。また、新たな観光・旅行・ショッピング・レジャーなどの産業創出によって、国民の利便性と生きがいを飛躍的に向上し、クリーンで省エネルギーな社会における健やかで快適な生活が実現されると見込まれています(図25)。

図25 テレイグジスタンスによる遠隔就労

| テレイグジスタンスとは | テレイグジスタンスの現在 | テレイグジスタンスの社会実装 | テレイグジスタンスとテレプレゼンスの違い |

| テレイグジスタンス黎明期 | テレイグジスタンス発見の瞬間 | テレイグジスタンスはいかにして生まれたか |

| 大型プロジェクト「極限作業ロボット」 | その後のテレイグジスタンス | これからのテレイグジスタンス | 参考文献 |

参考文献

[舘 1982] 舘 暲,阿部 稔:”テレイグジスタンスの研究(第1報)―視覚ディスプレイの設計―“, 第21回SICE学術講演会, pp.167-168, 1982. [PDF]

[舘、小森谷1982] 舘 暲, 小森谷 清: “第3世代ロボット”, 計測自動制御学会誌 計測と制御, Vol.21, No.12, pp.1140-1146, 1982. [PDF]

[舘 1986] 舘 暲: テレイグジスタンス -未来の夢と現在の技術-, 日本ロボット学会誌, Vol.4, No.3, pp.295-300, 1986. [PDF]

[舘、荒井 1989] 舘 暲, 荒井裕彦: テレイグジスタンスにおける視覚情報提示系の設計と評価日本ロボット学会誌, Vol.7, No.4, pp.314-326, 1989. [PDF]

[舘 1991] 舘 暲: テレイグジスタンス, 計測自動制御学会誌 計測と制御, Vol.30, No.6, pp.465-471 (1991.6) [PDF]

[舘、廣瀬 1992] 舘 暲, 廣瀬通孝 (編著): バーチャル・テック・ラボ, 工業調査会, 1992.

[舘 1992] 舘 暲: 人工現実感, 日刊工業新聞社, ISBN4-526-03189-5, 1992.

[舘 1997] 舘 暲: バーチャルリアリティとロボティクス, 日本ロボット学会誌, Vol.15, No.4, p.512-515, 1997. [PDF]

[舘ほか2011] 舘 暲・佐藤 誠・廣瀬通孝(監修・執筆),日本バーチャルリアリティ学会編:バーチャルリアリティ学,コロナ社,

ISBN978-4-904490-05-1, 2011. https://vrsj.org/publications/virtualreality/

[舘 2002] 舘 暲: バーチャルリアリティにおける触覚の役割, 電気学会論文誌E,Vol.122, No.10, pp.461-464, 2002. [PDF]

[渡邊ほか 2012] 渡邊孝一, 南澤孝太, 新居英明, 舘 暲: 全周囲裸眼立体ディスプレイを用いたサイバースペースへのテレイグジスタンス,日本バーチャルリアリティ学会論文誌, Vol.17, No.2, pp91-100, 2012. [PDF]

[舘ほか 2012] 舘 暲, 渡邊孝一, 竹下佳佑, 南澤孝太, 吉田匠, 佐藤克成:再帰性投影技術と全周囲裸眼3Dディスプレイを用いて存在感と臨場感を実現する相互テレイグジスタンスシステム:TELESAR4, 日本バーチャルリアリティ学会論文誌, Vol.17, No.1, pp.11-21, 2012. [PDF]

[舘 2015] 舘 暲: テレイグジスタンス, 日本ロボット学会誌, Vol.33, No.4,pp.215-221, 2015. [PDF]

[舘 2016] 舘 暲:20年後のテレイグジスタンス、日本バーチャルリアリティ学会誌、Vol.21, No.3, pp.34-37, 2016. [PDF]

[舘 2018] 舘 暲:テレイグジスタンスの新展開、日本ロボット学会誌、vol.36, no.10, pp.2-6, 2018. [PDF]

[井上ほか 2019] 井上 康之, ムハマド ヤーメン サライジ, 加藤 史洋, 舘 暲:テレイグジスタンスロボットにおける身体表現機能のVR拡張, 日本バーチャルリアリティ学会論文誌, vol.24, no.1,pp.137-140, 2019. [PDF]

[舘 2019] 舘 暲:テレイグジスタンスと時空間瞬間移動産業、自動車技術、vol.37, no.12, pp.17-23, 2019. [PDF]

[舘 2020] 舘 暲:テレイグジスタンス 新しい働き方と生き方、建設機械施工、vol.72, no.7, pp.16-22, 2020. [PDF]

[舘 2021] 舘 暲:コロナ危機後の社会とテレイグジスタンス、光技術コンタクト、vol.59, no.2, pp.1-5, 2021. [PDF]

[舘 2021b] 舘 暲:テレイグジスタンス研究の現状と社会実装、ロボット、no.261, pp.6-11, 2021. [PDF]

[Tachi et al. 1984] S.Tachi, K.Tanie, K.Komoriya and M.Kaneko: Tele-existence(I): Design and Evaluation of a Visual Display with Senstion of Presence, in A.Morecki et al. ed., Theory and Practice of Robots and Manipulators, pp.245-254, Kogan Page, 1984. [PDF]

[Tachi and Yasuda 1994] Susumu Tachi and Ken-ichi Yasuda: Evaluation Experiments of a Telexistence Manipulation System, Presence, Vol.3, No.1, pp.35-44, 1994. [PDF]

[Tachi et al. 2003] Susumu Tachi, Kiyoshi Komoriya, Kazuya Sawada, Takashi Nishiyama, Toshiyuki Itoko, Masami Kobayashi and Kozo Inoue: Telexistence Cockpit for Humanoid Robot Control, Advanced Robotics, Vol.17, No.3, pp.199-217, 2003. [PDF]

[Tachi et al. 2008] Susumu Tachi, Naoki Kawakami, Hideaki Nii, Kouichi Watanabe and Kouta Minamizawa: TELEsarPHONE: Mutual Telexistence Master Slave Communication System based on Retroreflective Projection Technology, SICE Journal of Control, Measurement, and System Integration, Vol.1, No.5, pp.335-344, 2008. [PDF]

[Tachi 2010] Susumu Tachi: Telexistence, World Scientific, ISBN-13 978-981-283-633-5, 2010. http://www.worldscientific.com/worldscibooks/10.1142/9248

[Tachi et al. 2012] Susumu Tachi, Kouta Minamizawa, Masahiko Furukawa and Charith Lasantha Fernando: Telexistence - from 1980 to 2012, Proceedings of IEEE/RSJ International Conference on Intelligent Robots and Systems (IROS2012), pp.5440-5441, Vilamoura, Algarve, Portugal, 2012. [PDF] video

[Tachi 2015] Susumu Tachi: Telexistence -Past, Present, and Future-, in G. Brunnett et al. ed. Virtual Realities, ISBN 978-3-319-17042-8, Springer, pp.229-259, 2015. https://link.springer.com/chapter/10.1007/978-3-319-17043-5_13

[Scoică 2015] Adrian Scoică: Susumu Tachi -The Scientist who Invented Telexistence, ACM Crossroads, vol.22, no.1, pp.61-62, 2015. [PDF]

[Tachi 2016] Susumu Tachi: Telexistence: Enabling Humans to be Virtually Ubiquitous, Computer Graphics and Applications, vol. 36, No.1, pp.8-14, 2016. [PDF]

[Tachi 2016b] Susumu Tachi: Memory of the Early Days and a View toward the Future, Presence, Vol.25, No.3, pp.239-246, 2016. [PDF]

[Tachi et al. 2020] Susumu Tachi, Yasuyuki Inoue and Fumihiro Kato: TELESAR VI: Telexistence Surrogate Anthropomorphic Robot VI, International Journal of Humanoid Robotics, Vol. 17, No. 5, p.2050019(1-33), 2020. [PDF] video